5 maneras de aumentar la oferta de energía para la IA sin construir más infraestructura

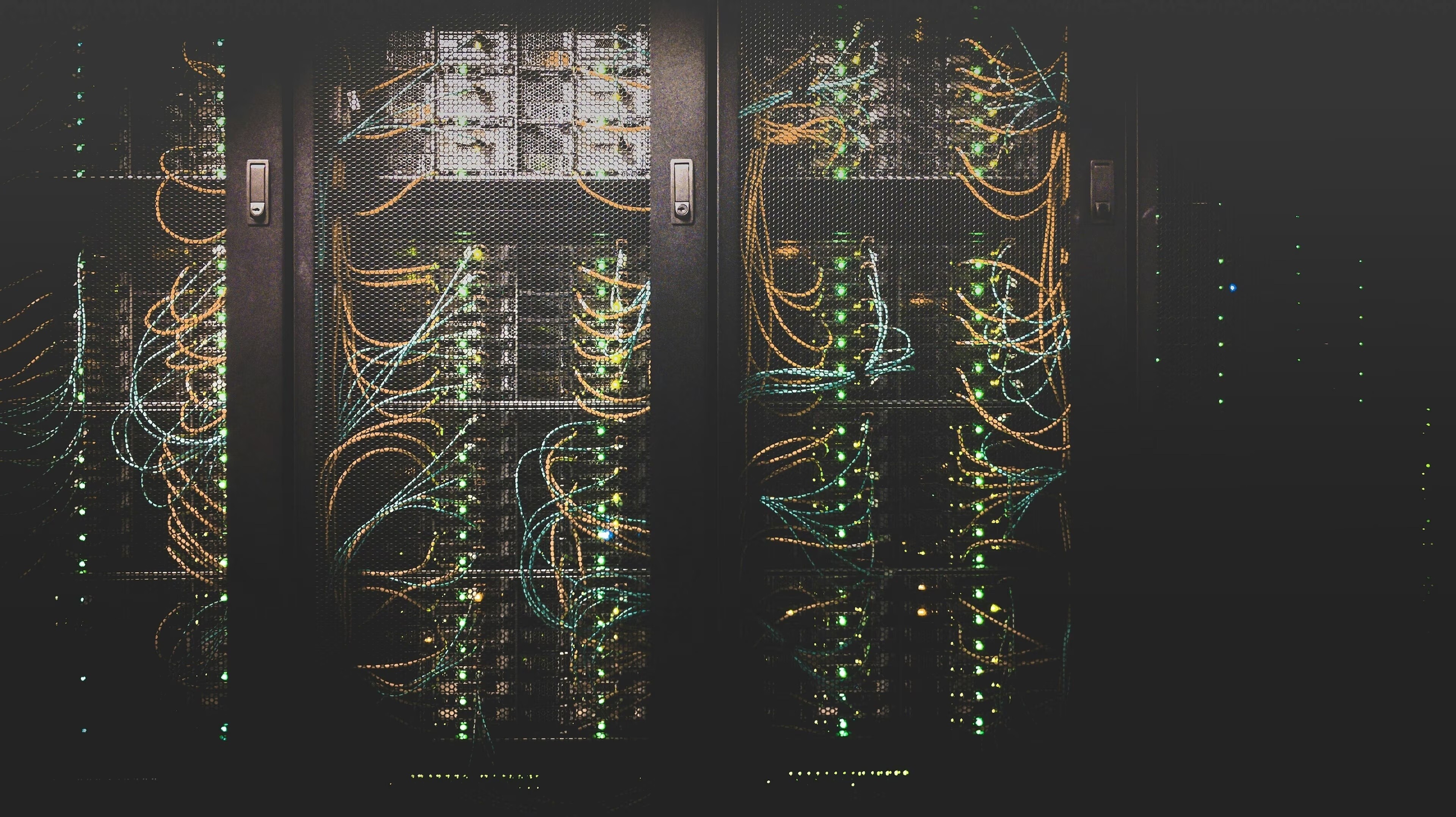

Una mayor eficiencia dentro de los propios centros de datos podría liberar más energía para la IA. Image: Unsplash/Taylor Vick

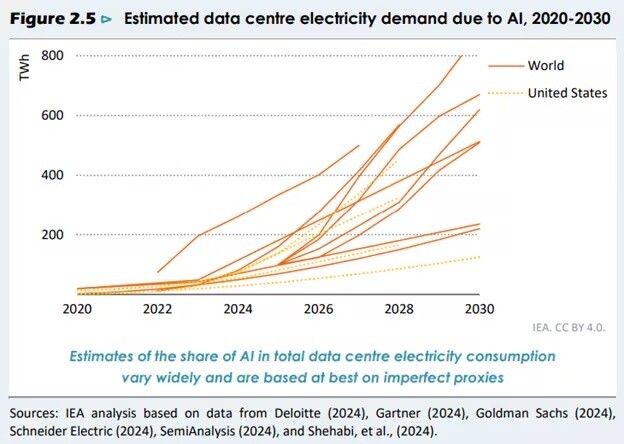

- El consumo de energía de la IA está aumentando rápidamente, mientras que la infraestructura eléctrica lucha por mantenerse al ritmo.

- Para poder satisfacer esta demanda de energía, debemos exprimir más capacidad eléctrica de los sistemas existentes.

- Las técnicas de enfriamiento de centros de datos, la programación flexible y el aprovechamiento del potencial de planificación de la propia IA se encuentran entre las innovaciones ya disponibles.

La inteligencia artificial está impulsando un aumento sin precedentes en la demanda de electricidad de los centros de datos. Sin embargo, construir nueva generación de electricidad y transmisión de la red es costoso, lento y a menudo políticamente complicado. La acumulación de pedidos para turbinas de gas ya se extiende hasta la década de 2030. Peor aún, las nuevas líneas de transmisión pueden tardar entre 10 y 15 años en ser aprobadas en Estados Unidos, sin contar siquiera el tiempo de construcción.

Entonces, ¿cómo podemos alimentar el crecimiento de la IA sin esperar a nuevas plantas de energía y líneas de red? Una oportunidad radica en exprimir más energía utilizable de los sistemas que ya tenemos.

Las empresas líderes están implementando innovaciones que liberan capacidad energética de otras tareas críticas dentro del centro de datos, de modo que más electricidad pueda destinarse directamente a la IA; de hecho, algunas de estas técnicas pueden adaptarse a centros de datos más antiguos. Con estas técnicas se pueden desbloquear gigavatios de capacidad eléctrica extra para la IA, todo sin necesidad de nueva infraestructura eléctrica.

Aquí compartimos cinco enfoques posibles:

1. Enfriamiento mediante el escape de la generación de energía in situ

Cada vatio consumido por los servidores se convierte en calor que debe ser eliminado por unidades de enfriamiento que consumen mucha electricidad. Es común que la refrigeración consuma un 30 a 40 % de la carga eléctrica de un centro de datos.

La generación de energía en el mismo lugar y en centros de datos es una opción cada vez más popular dadas las limitaciones de la red ridículas que enfrentan muchos países occidentales. Aquí surge una oportunidad inusual: las turbinas de gas o las pilas de combustible in situ pueden suministrar electricidad directamente, mientras que el calor residual de sus escapes puede utilizarse para impulsar una tecnología llamada “enfriadores por absorción” para ofrecer refrigeración.

El enfriamiento por absorción es como usar fuego para hacer hielo: suena paradójico, pero aun así la física lo permite. El calor residual del generador de electricidad se utiliza para hervir un “fluido de trabajo” especial, que se usa para bombear calor —básicamente mover calor de un lugar a otro— con el fin de enfriar otras sustancias (por ejemplo, producir agua fría para enfriar los sistemas e instalaciones del centro de datos).

Así, la generación de energía in situ produce tanto computación, calor como refrigeración —como en este ejemplo en Beijing, que aprovecha la tecnología de trigeneración de Jenbacher— y de este modo libera el uso de electricidad de la red destinada a la refrigeración para la IA.

2. Entregar energía de manera eficiente a través de voltajes más altos

Nuestra red eléctrica funciona con corriente alterna de alto voltaje, ya que un voltaje más alto implica menos pérdidas en el suministro de energía. Sin embargo, los ordenadores funcionan con corriente continua de bajo voltaje. Para convertir entre estos polos opuestos, se consume una cantidad considerable de electricidad antes de que llegue a un chip de IA.

Cada vez que se convierte el voltaje —desde el suministro de alta tensión de la red eléctrica, normalmente en el rango de 10.000 a 100.000 voltios, pasando por múltiples pasos hasta los 12 voltios para los componentes informáticos (un estándar omnipresente durante medio siglo), y luego al voltaje inferior a 1 voltio utilizado por los chips de IA— se pierde una cantidad significativa de electricidad.

Los centros de datos modernos finalmente están optimizando esta cadena hacia voltajes más altos. Un nuevo estándar industrial de 48 voltios está surgiendo de los hiper-escaladores (los gigantes tecnológicos como Amazon y Microsoft, que gestionan centros de datos masivos). Esto se traduce en una reducción de 16 veces en las pérdidas resistivas en los cables y conectores de los ordenadores. La actualización a voltajes más altos permite a los operadores soportar más computación de IA con la misma entrada eléctrica de la red.

Actualmente, Nvidia está probando racks de servidores que requieren arquitecturas incluso superiores a 48 voltios, por ejemplo, hasta 400 voltios. Por lo tanto, los centros de datos en fase de planificación deben anticiparse a estas arquitecturas de mayor voltaje para prepararse para el futuro.

3. Sumergir los servidores en líquido para una refrigeración eficiente

Gran parte de la refrigeración tradicional de computadoras se realiza con aire, como los ventiladores mecánicos cuyo zumbido quizás hayas notado en tus laptops y computadoras de escritorio.

Sin embargo, los líquidos transfieren el calor hasta 1.000 veces mejor que el aire, de manera similar a como sumergir una sartén caliente en agua la enfría más rápido que dejarla en la encimera. Si pudiéramos sumergir los chips de las computadoras en agua, podríamos hacer la refrigeración mucho más eficiente. La parte complicada es que no se puede usar agua directamente, ya que crearía cortocircuitos en los componentes electrónicos.

Afortunadamente, las empresas han inventado fluidos especiales que no conducen electricidad, junto con tanques sellados y diseños de servidores personalizados, para permitir una refrigeración mucho más eficiente. Esto se llama refrigeración por inmersión.

Los servidores con refrigeración por inmersión usan un 30 a 50 % menos de energía que los equivalentes refrigerados por aire. Así, para nuevos clústeres de IA de alta densidad, al reducir la carga eléctrica necesaria, la refrigeración por inmersión aumentaría dramáticamente la capacidad de computación soportada por las fuentes de energía existentes.

Las empresas ahora están escalando soluciones integradas, y fabricantes de chips y servidores como Intel y Dell están certificando hardware para este tipo de líquidos. Microsoft incluso está explorando sistemas de refrigeración por inmersión “bifásicos” más avanzados, para aprovechar la mayor eliminación de calor mediante la ebullición del líquido, en sus clústeres de Azure.

4. Desplazamiento de la carga: tiempo de computación y almacenamiento de energía

Los centros de datos tradicionales se construyen alrededor de una obsesión: el tiempo de actividad. El estándar de oro es “cinco nueves”, lo que significa un 99,999% de disponibilidad, o apenas cinco minutos de inactividad por año. Esto tiene sentido para el comercio financiero o la videoconferencia, donde incluso una breve interrupción es catastrófica.

Las cargas de trabajo de IA son mucho más flexibles. Entrenar modelos grandes permite pausar y reanudar desde puntos de control sin perder progreso. Las tareas de inferencia, como responder a una consulta de ChatGPT, se preocupan por la latencia y el rendimiento, no por la consistencia perfecta: si un servidor falla a mitad de la solicitud, el tráfico simplemente puede redirigirse.

Esta flexibilidad abre la puerta a un uso más inteligente de la energía. Los centros de datos de IA pueden desplazar las cargas de trabajo a momentos en que la electricidad es abundante y evitar los picos cuando la energía es escasa. Aún mejor, el almacenamiento de energía puede amplificar el efecto. El almacenamiento térmico puede producir hielo o agua fría por la noche y cubrir hasta el 30 % de las necesidades de refrigeración durante el día. Las baterías, ya estándar para respaldo, también pueden descargarse durante momentos de tensión en la red y recargarse en horas de baja demanda. Los gigantes tecnológicos ahora programan trabajos no urgentes para horas en que las energías renovables son abundantes, absorbiendo electricidad que de otro modo se desperdiciaría.

En resumen, la mayor flexibilidad en la demanda de la IA, combinada con el almacenamiento eléctrico y térmico, puede desbloquear capacidad de computación adicional sin necesidad de nuevas plantas de energía.

5. AI para optimizar las operaciones de los centros de datos

Es lógico que la IA pueda aumentar la eficiencia de los propios centros de datos. En 2016, DeepMind de Google demostró que, al aprovechar un sistema de control basado en una red neuronal profunda y entrenarlo con datos recopilados por miles de sensores, su sistema logró reducir en un 40 % el consumo de energía para refrigeración en un centro de datos en funcionamiento.

Una década después, los operadores están extendiendo los controles de IA más allá de la refrigeración; por ejemplo, apagando servidores inactivos, pronosticando cargas de trabajo o utilizando gemelos digitales de la termodinámica de las instalaciones. Estas optimizaciones basadas en software son rápidas de implementar, requieren poco capital y pueden generar ganancias de capacidad que de otro modo requerirían nueva infraestructura de hardware. Desde empresas consolidadas como Nvidia y Schneider Electric hasta startups innovadoras como Phaidra, ahora existen soluciones de software para la gestión de infraestructura de centros de datos que, a su vez, aprovechan técnicas de IA para aumentar aún más la eficiencia.

El crecimiento de la inteligencia artificial choca con los límites estrictos de la infraestructura energética. Las nuevas plantas de energía y líneas de transmisión no se construyen lo suficientemente rápido, y probablemente no lo harán, incluso con la reforma de permisos federales en marcha, dado los múltiples obstáculos para construir nueva infraestructura energética a nivel estatal y local.

La eficiencia está surgiendo como la fuente oculta de energía, capaz de desbloquear gigavatios de capacidad eléctrica. Esto no es teórico: las cinco técnicas mencionadas anteriormente ya están en fase de piloto hasta despliegue completo. Cada enfoque extrae más computación útil e inteligencia de cada kilovatio que fluye hacia nuestros centros de datos.

¿Qué está haciendo el Foro Económico Mundial en el ámbito de la transición a una energía limpia?

Invertir en estas medidas es una victoria estratégica triple. Aborda los cuellos de botella energéticos inmediatos que limitan el crecimiento de la IA, se alinea con los objetivos globales de sostenibilidad y ahorra en gastos operativos. La innovación es nuestro mejor combustible: no se requieren permisos ni nuevas plantas.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

Energy Innovation

Temas relacionados:

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre Transición energéticaVer todo

Lee Beck

11 de febrero de 2026