La ansiedad pública, un reto clave en la era de la IA

Existe una creciente ola de inquietud pública en lo que respecta a la IA. Image: REUTERS/Dado Ruvic

- La preocupación pública por la IA está aumentando como consecuencia de la falta de transparencia, los temores a la pérdida de empleos y las inquietudes sobre los sesgos y la privacidad de los datos.

- Esta inquietud supone un desafío crítico, que amenaza con socavar la legitimidad y la adopción beneficiosa de la IA en la sociedad.

- En lugar de considerar estas reticencias como tecnofobia, debemos tratar la preocupación como una señal clave de que se necesita más gobernanza, inclusión y transparencia en los sistemas de IA.

Hoy en día, la inteligencia artificial (IA) ya no es una novedad, sino una parte esencial de nuestra vida cotidiana: en los algoritmos de recomendación, los asistentes inteligentes o los procesos automatizados de toma de decisiones. Sin embargo, está aumentando la inquietud de la población. Lejos de ser una mera tecnofobia, esta inquietud es señal de algo más profundo: un desajuste entre el ritmo de la innovación y nuestra capacidad colectiva para comprender, influir y convivir con la IA. Abordar esta ansiedad es ahora más importante que nunca: la respuesta de la sociedad determinará la legitimidad, la dirección y los beneficios de la IA en los próximos años.

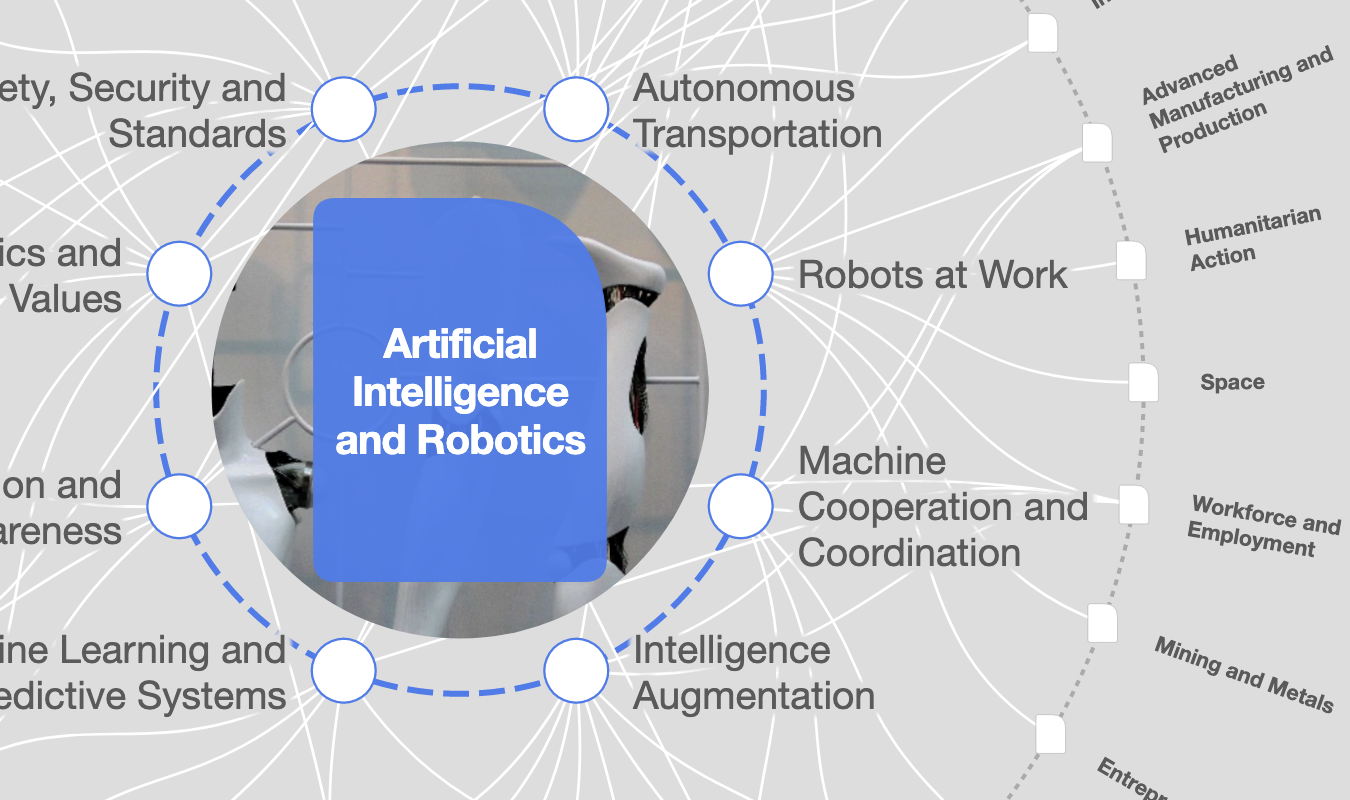

¿Qué está haciendo el Foro Económico Mundial en el ámbito de la cuarta revolución industrial?

Las fuentes de malestar

Esta ansiedad tiene múltiples dimensiones: falta de transparencia en los mecanismos de la tecnología, temores relacionados con el empleo y la economía, preocupaciones sobre la privacidad y los sesgos, y la sensación de que la IA avanza más rápido de lo que las personas pueden comprender.

El efecto "caja negra"

Una fuente de ansiedad es la falta de transparencia de la IA. Por lo general, no sabemos cómo los modelos llegan a sus respuestas: si se basan en sesgos, si se entrenan con información desactualizada o si son creados mediante procesos de entrenamiento dudosos. Este «efecto caja negra» y sus resultados incontrolables generan una profunda desconfianza que provoca un rechazo generalizado a la adopción de la IA.

Miedo a la pérdida de empleo y los trastornos económicos

Con el uso cada vez más extendido de los sistemas de IA, los informes revelan que muchas personas están preocupadas por que sus datos personales se recopilen sin su consentimiento, por la imposibilidad de distinguir entre contenido real y sintético, y por el sesgo de la IA en las decisiones de contratación, control policial y concesión de créditos. En los lugares de trabajo, "muchos empleados se preocupan de que la IA monitoree sus patrones de trabajo, sus comunicaciones e incluso sus descansos para ir al baño", informa Forbes. Sin transparencia sobre lo que se monitorea, cómo se utilizan los datos o cómo se toman las decisiones, la confianza se erosiona rápidamente.

La velocidad del cambio y la sensación de quedarse atrás

Quizás lo más fundamental es que muchos sienten que la IA avanza a una velocidad que supera tanto a la regulación como al debate público. La OCDE advirtió que, si bien las capacidades de la IA han avanzado exponencialmente, las respuestas políticas siguen siendo "fragmentadas y reactivas". La percepción de quedarse atrás crea una sensación de impotencia que alimenta la inquietud pública.

Por qué es importante tener en cuenta la preocupación pública por la IA

La IA no es simplemente un nuevo dispositivo, es un cambio fundamental en la forma de hacer las cosas. En el sector público, datos de la OCDE muestran que los gobiernos están adoptando cada vez más la IA para mejorar la eficiencia y la accesibilidad de los servicios, y el Foro Económico Mundial estima que la IA creará 69 millones de nuevos empleos en todo el mundo para 2028.

No se puede seguir ignorando esta ansiedad y este malestar hacia la IA. A medida que los sistemas de IA se integran cada vez más en la vida cotidiana, la importancia de hacerlo bien es mayor, ya que hay mucho en juego. Además, el desajuste entre el ritmo de la innovación y los mecanismos de gobernanza es más pronunciado que nunca. La rapidez de la adopción, combinada con una transparencia limitada, hace que el riesgo de reacciones adversas sea inminente.

Por último, la ansiedad puede reforzarse a sí misma. Si muchos miembros del público, así como las organizaciones, se resisten o se desvinculan de la IA, la promesa de la IA podría verse socavada. Esto podría frenar o distorsionar la integración y adopción de la IA, lo que sería perjudicial tanto para esta promesa como para las personas.

Replantear la ansiedad como señal

En lugar de restar importancia a la preocupación pública sobre la IA y considerarla simplemente como "miedo a la tecnología", es más útil tratarla como un mecanismo vital de retroalimentación, una señal de que debemos dar un paso atrás, abrir el diálogo y tender puentes. Hay tres imperativos que destacan:

Transparencia y explicación: Los sistemas no solo deben funcionar, sino que también deben ser comprensibles de manera coherente. Esto es indicativo de la necesidad de una mejor educación, una comunicación más clara y un diseño transparente y explicable. Cuanto menos misterioso sean los sistemas, menos espacio habrá para alimentar el miedo.

Inclusión y diálogo: La ansiedad suele reflejar la sensación de sentirse excluido o ignorado. La confianza en el uso de la IA no solo depende de su robustez técnica, sino también de la participación pública, de un proceso inclusivo de toma de decisiones y de la posibilidad de opinar sobre su diseño, implementación y supervisión. Por ejemplo, el 73% de los expertos opinan que se tienen en cuenta las opiniones de la población adulta blanca en el diseño de la IA, pero solo el 27% dice lo mismo sobre la población adulta negra. Esta brecha es una clara señal de la necesidad de una mayor inclusión.

Gobernanza y rendición de cuentas: Los ciudadanos no temen solo a los sistemas de IA en sí, sino también a las instituciones que están detrás de ellos. "No confío en que los ejecutivos de las empresas tecnológicas se autorregulen" es una respuesta que aparece repetidamente en las encuestas. Si queremos ganarnos la confianza de los ciudadanos, no basta con que existan marcos normativos, sino que estos deben ser visibles, ágiles y legitimados.

Un llamamiento al diálogo

La ansiedad en torno a la IA es una señal para acelerar nuestro trabajo colectivo sobre la infraestructura social de la IA. Los avances técnicos por sí solos no son suficientes, lo que importa es cómo las personas, las comunidades y las organizaciones experimentan la IA: si se sienten en control, si confían en los sistemas que afectan a sus vidas.

La tecnología seguirá avanzando rápidamente. Pero el lado humano —la educación, el diálogo, la gobernanza— debe seguir el ritmo. De lo contrario, corremos el riesgo de crear sistemas poderosos en sociedades que aún no han alcanzado un consenso sobre su función, sus limitaciones o sus valores. En este momento, en el que la integración de la IA se está profundizando, pero la comprensión y la confianza del público siguen siendo frágiles, fomentar la confianza del público en la IA no es opcional, sino fundamental para garantizar que estas tecnologías sirvan a la sociedad, en lugar de alienarla.

Cuando la ansiedad sobre la IA se trata como una señal para actuar, abrimos la posibilidad de una era de IA más inclusiva, transparente y meditada. Por eso este momento es importante, y por eso abordar la incertidumbre del público es un reto decisivo y una oportunidad en la era de la IA.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

Strategic Foresight

Temas relacionados:

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre Inteligencia artificialVer todo

Jessica Apotheker

11 de febrero de 2026