La confianza es la nueva moneda en la economía de los agentes de IA

La economía de los agentes de IA podría romper la confianza... o transformarla. Image: Getty Images

- El crecimiento de la economía de los agentes de IA supone una amenaza para los niveles de confianza, pero también ofrece oportunidades para reimaginar la confianza.

- La confianza en la IA es bidimensional, ya que depende de la percepción de la competencia y la intención de la tecnología.

- A medida que prolifera la IA autónoma, debemos replantearnos la confianza en tres niveles diferentes.

Como observó en una ocasión el premio Nobel Kenneth Arrow, toda transacción económica contiene un elemento de confianza. Hoy en día, a medida que los agentes de IA gestionan un número cada vez mayor de transacciones, esa confianza se enfrenta a nuevas presiones. Los niveles de confianza a nivel mundial están disminuyendo, mientras que la presencia de agentes de IA en nuestra vida cotidiana y en los sistemas empresariales está aumentando rápidamente.

En un escenario pesimista, esto podría erosionar la confianza. En uno optimista, abre vías para reimaginar la confianza e impulsar el crecimiento económico.

La relación entre confianza social y resultados económicos está ampliamente documentada. Según Deloitte Insights, un aumento de 10 puntos porcentuales en la proporción de personas que confían en su país debería incrementar el crecimiento anual del PIB real per cápita en aproximadamente 0,5 puntos porcentuales. Sin embargo, esa relación está evolucionando a medida que avanzamos de las interacciones entre seres humanos hacia los intercambios agenciales.

La confianza seguirá determinando los resultados en la economía impulsada por la IA. La verdadera pregunta es: ¿qué tipo de confianza será más importante y cómo la construimos?

Hacia una economía basada en agentes de IA

La economía digital se está volviendo agéntica. Los agentes de IA están pasando de ser herramientas de asistencia a entidades autónomas que ejecutan transacciones, asignan recursos y toman decisiones.

La IA ha madurado a lo largo de décadas, pero hoy marca un punto de inflexión. Según el Ciclo de hype de Gartner para la inteligencia artificial, los agentes de IA se encuentran en la cima de las expectativas, con un período de implementación previsto de entre 2 y 5 años. Para 2028, alrededor del 33% de las aplicaciones de software empresarial incluirán IA autónoma, y al menos el 15% de las decisiones diarias se tomarán de forma autónoma a través de agentes de IA. La economía de los agentes de IA será una realidad plenamente consolidada que requerirá formas totalmente nuevas de rendición de cuentas, colaboración y confianza.

En el centro de la confianza hay dos componentes fundamentales: la competencia (la capacidad de ejecutar) y la intención (el propósito detrás de las acciones). Si bien hoy en día pocos cuestionan la competencia de las tecnologías avanzadas, la intención sigue siendo una frontera difusa.

Por qué cambia la confianza y por qué es importante

Las investigaciones demuestran que la confianza en la IA varía significativamente entre regiones y grupos demográficos. Según una investigación realizada por KPMG y la Universidad de Melbourne, en los países avanzados la gente confía menos en la IA que en los países emergentes (39% frente a 57%) y la acepta menos (65% frente a 84%). Desde una perspectiva sociológica, en estos entornos, la confianza sigue basándose en las relaciones interpersonales o en las instituciones tradicionales.

El último informe Barómetro Global de la Confianza de Edelman describe el entorno actual como una "crisis de descontento". Cuanto mayor es el sentimiento de descontento, mayor es la desconfianza hacia la IA. Las personas que sienten una mayor sensación de injusticia o descontento son significativamente menos propensas a confiar en la IA y se muestran notablemente más incómodas con su uso por parte de las empresas. A medida que se erosiona la confianza en las instituciones, también lo hace la aceptación del papel cada vez más importante de la IA en las empresas y la gobernanza.

Será fundamental comprender cómo se forma la confianza.

Formas de adquirir confianza

A medida que proliferan los agentes autónomos de IA, debemos replantearnos cómo funciona la confianza en tres ámbitos clave:

- Confianza humano-humano. Las bases de la confianza interpersonal siguen siendo los valores compartidos, la reciprocidad y la experiencia acumulada. Sin embargo, la dimensión digital está cambiando la forma en que percibimos a los demás. Si una cara conocida en una videollamada puede ser un avatar generado por IA, las señales psicológicas en las que nos basamos para generar confianza se ven amenazadas. Esto plantea nuevas preguntas sobre autenticidad, identidad y normas de interacción en un mundo híbrido humano-IA.

- Confianza agente-agente. La confianza entre agentes de IA se forma a través del intercambio de señales: historial de comportamiento, datos de reputación y comportamiento predecible. Los agentes se evaluarán entre sí en función de su competencia (ejecución técnica, fiabilidad) y su intención (alineación de objetivos, transparencia en la toma de decisiones). La confianza en este ámbito se convierte en un problema de ingeniería: cómo diseñar sistemas que puedan evaluar, verificar y adaptar la confianza a lo largo del tiempo.

- Confianza humano-agente. Para que los seres humanos confíen en los agentes de IA, estos deben mostrar una identidad persistente y un comportamiento predecible. Las personas confían en la consistencia. Al igual que recordamos a los colaboradores fiables, los agentes de IA deben recordar y adaptarse a los usuarios, ofreciendo continuidad y coherencia en la interacción. La confianza se erosiona cuando la IA se comporta de forma errática o finge ser algo que no es. La autenticidad y la memoria deben estar integradas en el diseño de los agentes.

La confianza en la era de la IA

Uno de los mayores desafíos para la confianza en la IA sigue siendo la falta de claridad en torno a la intención de los agentes. Por ejemplo, los vehículos autónomos pueden ser estadísticamente más seguros que los conductores humanos, pero muchas personas siguen desconfiando de ellos debido a la incertidumbre sobre los valores que guían sus decisiones.

Esto apunta a una necesidad más amplia de intenciones transparentes y explicables dentro de los sistemas de IA – no solo capacidades, sino también motivaciones. Desde una perspectiva sistémica, también nos enfrentamos a desafíos técnicos: cómo garantizar un intercambio de datos fluido y seguro, cómo verificar la identidad de los agentes en diferentes plataformas y cómo crear protocolos comunes que permitan la transmisión no solo de información, sino también de la propia confianza.

Pero quizás el desafío más difícil radica en la mentalidad. Como observó la empresa de capital de riesgo Sequoia Capital, el éxito en la economía de los agentes de IA requiere más que una nueva tecnología: exige un nuevo tipo de liderazgo, que comprenda lo que los agentes de IA pueden y no pueden hacer, y cómo deben ser gobernados.

Una ventana de oportunidad

Los próximos cinco años ofrecen una ventana estrecha pero crucial para dar forma al funcionamiento de la confianza en un mundo de agentes autónomos. Según Grand View Research, se prevé que el mercado mundial de agentes de IA alcance los 50 310 millones de dólares en 2030. A medida que evolucione la economía de los agentes, lo que estará en juego será más importante que nunca. El fraude y las amenazas a la seguridad podrían multiplicarse exponencialmente a menos que se establezcan marcos de confianza sólidos.

¿Qué está haciendo el Foro Económico Mundial en el ámbito de la cuarta revolución industrial?

Los expertos han bautizado 2024 como "el año del deepfake". Con el tiempo, el desarrollo de agentes de IA autónomos y las posibilidades de falsificación y fraude no harán más que aumentar. Esto conlleva una disminución de la confianza y de los indicadores económicos. Por ejemplo, el Centro de Servicios Financieros de Deloitte prevé que la GenAI podría provocar pérdidas por fraude de hasta 40 000 millones de dólares solo en Estados Unidos. Las pérdidas a escala de la economía global superarán el tamaño del mercado de agentes de IA.

Podemos optar por dejar que aumente la desconfianza, impulsada por la confusión, la manipulación y la sobrecarga digital. O podemos construir nuevas arquitecturas de confianza, basadas en la claridad, la consistencia y los valores humanos compartidos, reforzadas por agentes inteligentes.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

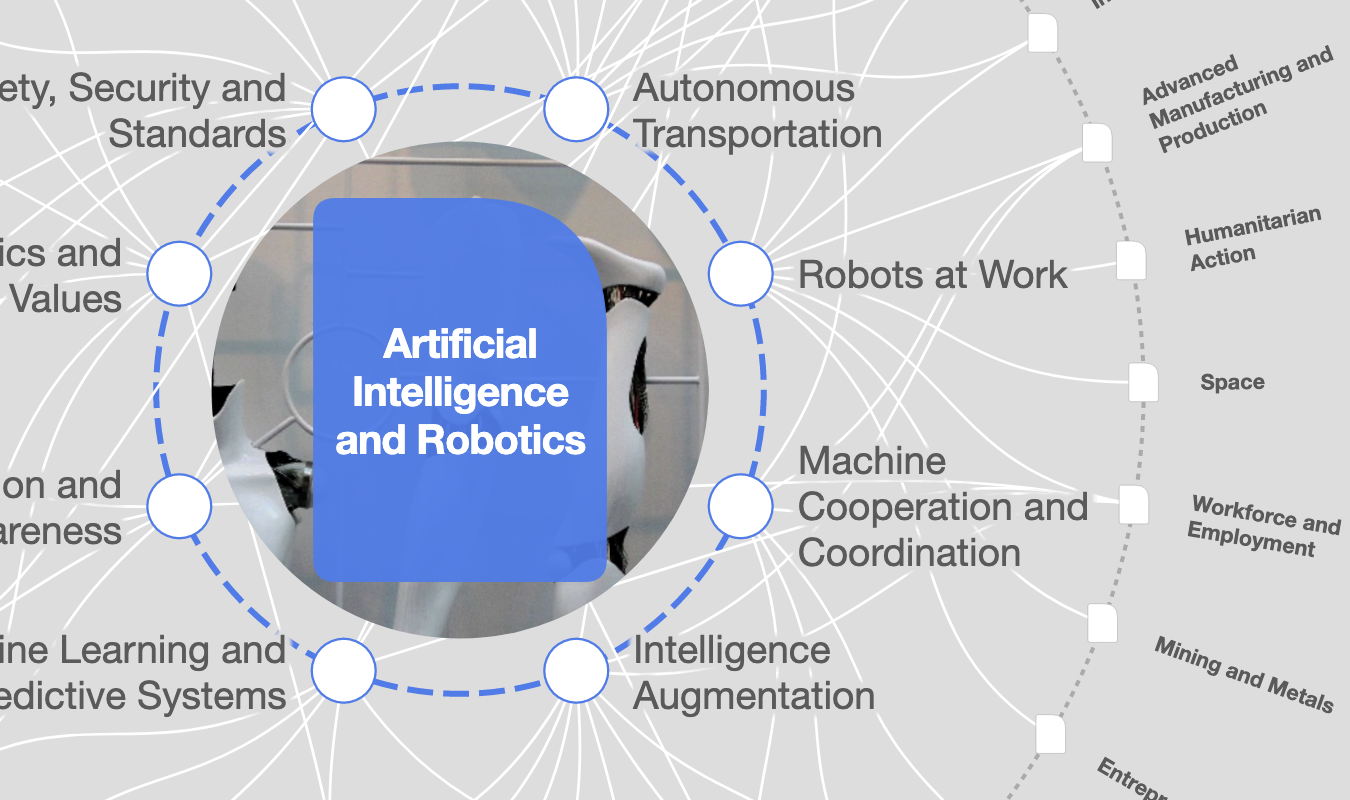

Inteligencia Artificial y Robótica

Temas relacionados:

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre Tecnologías emergentesVer todo

Kriti Sharma

11 de febrero de 2026