Por qué el código abierto es crucial para el desarrollo responsable de la IA

Una industria que fomente el desarrollo de código abierto puede conducir a una mayor creatividad y a una IA más segura. Image: Pixabay/Pexels

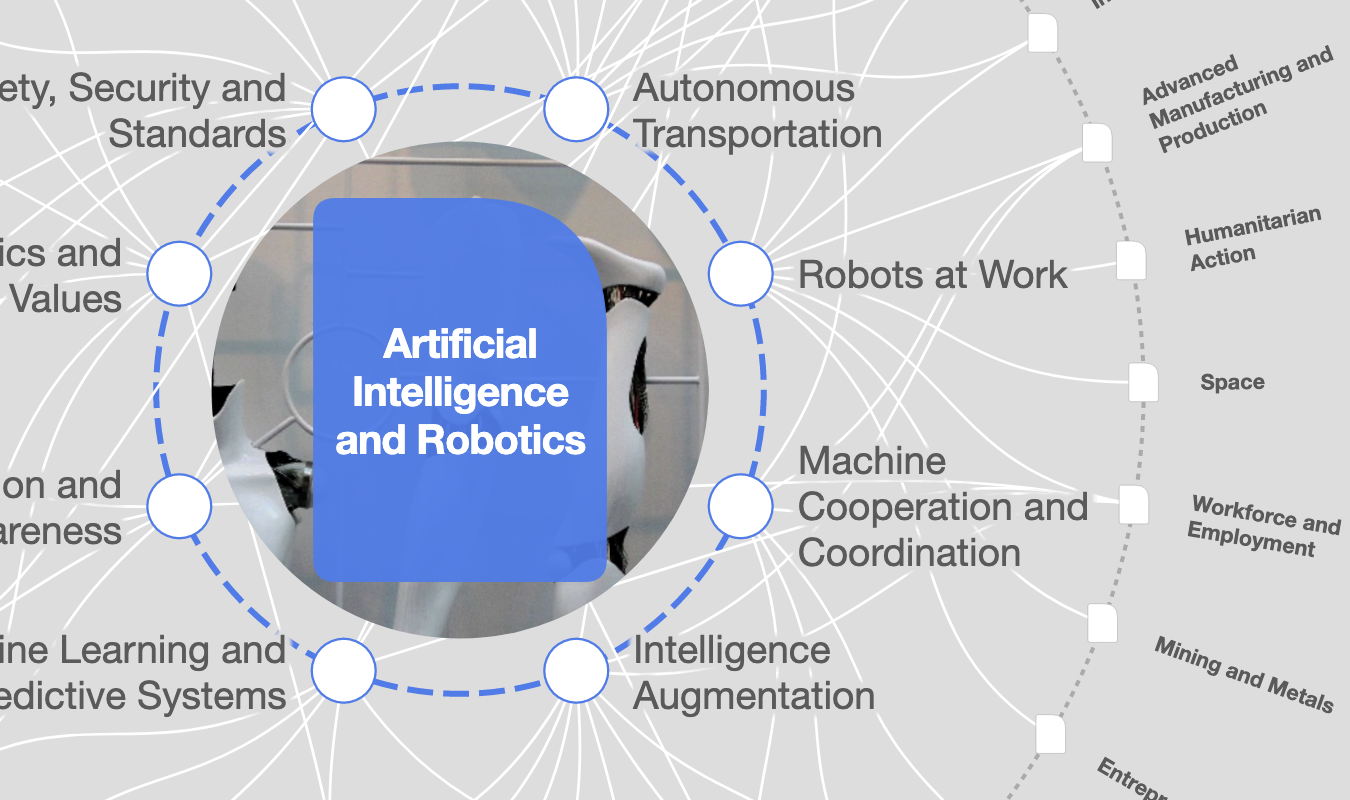

- En el centro de la regulación de la IA está la necesidad de un enfoque unificado del desarrollo y la implementación responsables de la IA.

- Un amplio abanico de tecnólogos debe involucrarse en las conversaciones sobre regulación para garantizar que ésta se desarrolle sin prejuicios.

- Sin puntos de vista variados, la regulaciones resultantes puede pasar por alto los modelos de código abierto, que deben ser la piedra angular de una IA responsable.

La inteligencia artificial (IA) es la fuerza tecnológica más poderosa que da forma a nuestro mundo actual. Tiene un enorme potencial para mejorar vidas, desde optimizar las cadenas de suministro globales hasta acelerar el proceso de descubrimiento de fármacos. Sin embargo, si no se utiliza con prudencia, la IA puede perpetuar los prejuicios, trastornar la industria e incluso reducir la creatividad y la conexión humanas, causando un daño real en nuestra vida cotidiana.

Con posibilidades radicalmente diferentes en juego, es fundamental que mantengamos una conversación meditada sobre cómo utilizar la IA en beneficio de la sociedad. Naturalmente, la regulación es y debe ser parte de esta conversación.

En el centro de la regulación está la necesidad de un enfoque unificado para el desarrollo y despliegue responsables de la IA. Del mismo modo que los modelos de IA deben entrenarse en diversos conjuntos de datos para garantizar la imparcialidad, una amplia gama de tecnólogos debe participar en las conversaciones sobre regulación para garantizar que esta se desarrolle sin sesgos. Sin puntos de vista variados, la regulación resultante puede pasar por alto los modelos de código abierto como piedra angular de la IA responsable.

Lo que falta en las actuales conversaciones sobre reglamentación

En EE. UU., la "Orden Ejecutiva sobre el Desarrollo y Uso Seguro y Fiable de la Inteligencia Artificial" del Presidente Biden aborda varios elementos críticos de la IA responsable a los que damos prioridad en Grammarly, entre ellos el desarrollo de estándares de fiabilidad y la ayuda a los educadores para desplegar herramientas de IA de forma segura.

Un aspecto en el que la postura de Grammarly difiere de la orden ejecutiva es su creencia en los modelos de código abierto como aspecto central del desarrollo responsable de la IA.

La sección 4.6 de la orden ejecutiva de Biden sugiere una preferencia por los modelos de código cerrado, posiblemente reflejando los puntos de vista de los gigantes tecnológicos que fueron consultados en su redacción. La administración está evaluando los modelos de código abierto de forma diferente a los de código cerrado y tiene previsto elaborar recomendaciones específicas para los modelos de código abierto.

Creo que tales restricciones al desarrollo de código abierto pueden perjudicar a la industria tecnológica y, en última instancia, al usuario final. No soy el único: se han hecho afirmaciones similares sobre la Ley de Inteligencia Artificial propuesta por la Unión Europea.

Para contextualizar, los modelos de código cerrado son mantenidos por una organización y su código no se pone a disposición del público para su uso o auditoría. Ejemplos de grandes modelos lingüísticos (LLM) de código cerrado son PaLM de Google, la familia de modelos GPT de OpenAI y Claude de Anthropic. Aunque terceros pueden aprovechar algunos modelos de código cerrado a través de una interfaz de programación de aplicaciones (API), el código en sí no puede manipularse.

Los modelos de código abierto, como Falcon LLM del Instituto de Innovación Tecnológica y Llama2 de Meta, son de uso y modificación públicos en nombre de la innovación. Tal y como implica la orden ejecutiva, a algunas personas les puede preocupar que agentes malintencionados puedan modificar intencionadamente el código de un modelo de código abierto, dando lugar a problemas de seguridad.

Estas vulnerabilidades no son distintas de los riesgos de ciberseguridad a los que debe enfrentarse todo software, y tanto el desarrollo de código cerrado como el de código abierto han sido aceptados durante décadas. Como señala una carta de Martín Casado, socio general de la empresa de capital riesgo Andreessen Horowitz, al Presidente Biden: el software de código abierto Linux se utiliza ampliamente en la computación en nube en todo el gobierno estadounidense.

De hecho, el uso de modelos de código abierto en las empresas va en aumento. El informe de Red Hat "The State of Enterprise Open Source 2022" sugiere que el 80% de los líderes de TI esperan aumentar el uso de software empresarial de código abierto y el 89% cree que el código abierto es tan o más seguro que su alternativa.

Además, una industria que fomente el desarrollo de código abierto puede dar lugar a:

- Mayor creatividad, innovación y competencia: La disponibilidad de modelos de IA de código abierto ha reducido significativamente el tiempo y los recursos necesarios para desarrollar nuevas aplicaciones y ha puesto la IA al alcance de un mayor número de desarrolladores, fomentando la competencia más allá de las grandes empresas tecnológicas.

- Una IA más segura: cuando los modelos están a disposición del público, no sólo ayudan a los desarrolladores a crear nuevas aplicaciones, sino que también les permiten fabricar productos más seguros. Seismograph, por ejemplo, es un modelo de código abierto que puede utilizarse para ayudar a los asistentes de escritura de IA a interactuar con contenidos sensibles de forma responsable.

- Mayor transparencia: Los conjuntos de datos y los códigos de los modelos de código abierto pueden ser auditados y verificados por terceros, lo que contribuye a garantizar su calidad y fiabilidad.

Merece la pena subrayar este último punto. La orden ejecutiva de Biden se centra en muchos de los aspectos más importantes de la IA responsable (seguridad, protección y fiabilidad), pero no dedica mucho espacio a un elemento crucial: la transparencia.

Sin transparencia, es difícil que la gente se forme una opinión sobre si una herramienta de IA es segura y digna de confianza. Si bien la regulación debe explorar muchas formas de mejorar la transparencia -desde compartir las prácticas de recopilación de datos hasta implementar bucles de retroalimentación continuos-, los modelos de código abierto son un faro de transparencia en su propia existencia.

Los modelos de código abierto por sí solos no son el único camino a seguir; el software de código cerrado es una práctica habitual para que las empresas moneticen los productos de IA. Como CEO de una empresa tecnológica, comprendo perfectamente la necesidad de los modelos de código cerrado. Lo que temo es un futuro en el que todo el desarrollo de IA sea de código cerrado, lo que mermaría la innovación y los modelos de responsabilidad y transparencia que el desarrollo de código abierto aporta al sector.

¿Qué podemos hacer de otra manera?

En un mundo perfecto, los líderes tecnológicos podrían ver en la regulación la confirmación de que están haciendo bien la IA responsable. Por eso debemos compartir de forma proactiva nuestra experiencia a escala mundial para garantizar que las regulaciones se desarrollen de forma holística.

He aquí tres maneras en que la industria puede hacerlo:

- Contribuir al código abierto: Los modelos de código abierto de Grammarly lo cubren todo, desde la corrección de errores gramaticales con inclusión de género hasta la delicada interacción textual, ayudando a fomentar una asistencia a la escritura con IA más responsable. Al crear modelos de código abierto, podemos ayudar a una amplia gama de desarrolladores y sectores a crear los mejores productos.

- Crear y seguir un marco de IA responsable: En Grammarly, tenemos el marco TRUE. Cuando marcos intencionados como este se utilicen en todo el sector, muchos riesgos de las últimas tecnologías de IA se mitigarán mucho antes de que intervenga la regulación.

- Trabajar juntos, no unos contra otros: Como líderes de la IA comprometidos con la mejora de la sociedad, nuestro objetivo debe ser mejorar el uso de la IA para la sociedad en general. Forme equipo con sus colegas para dar prioridad a la IA responsable por encima de los egos o la competencia.

La marea alta levanta todos los barcos y la creación de una industria de la IA más fuerte y responsable nos ayuda a garantizar el éxito de su despliegue. Esto incluye proteger el derecho a compartir la tecnología de código abierto, lo que puede hacer que la IA sea más segura, transparente y útil.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

Tecnologías emergentes

Temas relacionados:

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre Tecnologías emergentesVer todo

Inna Tokarev Sela

13 de noviembre de 2025