¿Cómo hacemos que la inteligencia artificial sea más humana?

Image: REUTERS/Jason Lee

Nicholas Davis

Professor of Practice, Thunderbird School of Global Management and Visiting Professor in Cybersecurity, UCL Department of Science, Technology, Engineering and Public PolicyA todos nos ha pasado algo así: en un momento estamos buscando un regalo para un niño de dos años; al minuto, aparecen anuncios de pañales y cochecitos en cada sitio que visitamos.

Es inquietante. Nadie se siente cómodo con los robots que nos siguen de manera encubierta mientras navegamos por la web, o cuando las empresas utilizan lo que aprenden de nuestro comportamiento en línea para promocionar productos y servicios de forma escalofriante.

Pero, ¿podrían las preocupaciones acerca de la privacidad y el consentimiento informado —aunque de innegable importancia— distraernos de lo que realmente debería preocuparnos?

La explotación de la información personal con fines publicitarios es un problema real. Sin embargo, el riesgo más grave es que nuestra información personal se puede usar en nuestra contra, no solo para publicitar un producto que no deseamos, sino para discriminarnos en función de nuestra edad, raza, género o alguna otra característica que no podamos controlar.

Por ejemplo, si tiene una piel más oscura, la tecnología de reconocimiento facial es mucho menos precisa que si tuviera un cutis claro. A medida que esta tecnología se implementa de manera progresiva en la aplicación de la ley, en la seguridad fronteriza e incluso en la prestación de servicios financieros, el riesgo de que pueda verse injustamente perjudicado aumenta en función de su origen étnico.

De manera similar, hay ejemplos de inteligencia artificial (IA) que se utiliza para evitar que las mujeres o personas mayores puedan ver ciertas oportunidades de empleo en línea.

Esto no solo viola los derechos humanos de las personas afectadas negativamente, sino que también socava la confianza de la comunidad en la inteligencia artificial en general. Una pérdida de la confianza de la comunidad en la inteligencia artificial sería desastrosa, porque la IA puede ser de gran ayuda, no solo para nuestra economía, sino también para lograr que nuestra comunidad sea más inclusiva.

Por cada caso en que la IA causa daño, también hay un contraejemplo alentador. Esto presenta un carácter muy diverso: desde aplicaciones de teléfonos inteligentes con tecnología de IA, que permite a personas ciegas “ver” el mundo a que los rodea, hasta grandes avances en medicina de precisión.

Por lo tanto, nuestro desafío es generar confianza duradera en el desarrollo y uso de un conjunto de tecnologías realmente apasionantes, de modo que podamos aprovechar las oportunidades y enfrentar las amenazas a nuestros derechos básicos. Lamentablemente, este desafío se ve perjudicado por un mito perjudicial pero generalizado.

Con demasiada frecuencia se nos dice que, si Australia va a competir a nivel mundial en el desarrollo de productos de IA, los investigadores y las empresas australianas no deben verse limitados por las preocupaciones de derechos humanos, ya otros países no lo están. China, por ejemplo, está invirtiendo fuertemente en tecnología de IA como el reconocimiento facial para respaldar su sistema de “puntaje de crédito social”, que implica realizar una vigilancia precisa y determinativa de sus ciudadanos. En el contexto de una carrera armamentista mundial de inteligencia artificial, se argumenta, Australia no puede competir con un brazo atado a la espalda.

Este argumento es peligrosamente falso. Los valores democráticos liberales de Australia son su fortaleza. La consulta de la Comisión Australiana de Derechos Humanos sobre los derechos humanos y la tecnología ha demostrado que, a medida que los australianos aprenden más sobre la IA, existe una demanda creciente de que esta solo se utilice de manera que respete los derechos humanos.

Esto sugiere que incorporar la protección de los derechos humanos en la IA a medida que se desarrolla no solo es moralmente correcto, sino que también es inteligente. Si Australia puede llegar a ser conocida por desarrollar una IA que logre el equilibrio correcto, podemos obtener una ventaja competitiva.

Después de todo, en las democracias liberales los consumidores desean los beneficios de la IA, con vehículos autodirigidos, mejor asistencia médica y computadoras superpoderosas. Sin embargo, no aceptarán una solución intermedia que implique vigilancia masiva, la exclusión de grupos enteros y un aumento de la discriminación.

Sabemos que la tecnología —y especialmente la IA— se está desarrollando a una velocidad vertiginosa. También sabemos que nuestras leyes pueden ser lentas para adaptarse.

Esto ejerce una mayor presión sobre las instituciones australianas para suavizar cualquier aspereza de la IA en formas que nos permitan aprovechar las oportunidades sin permitir que los miembros vulnerables de la comunidad sean aplastados.

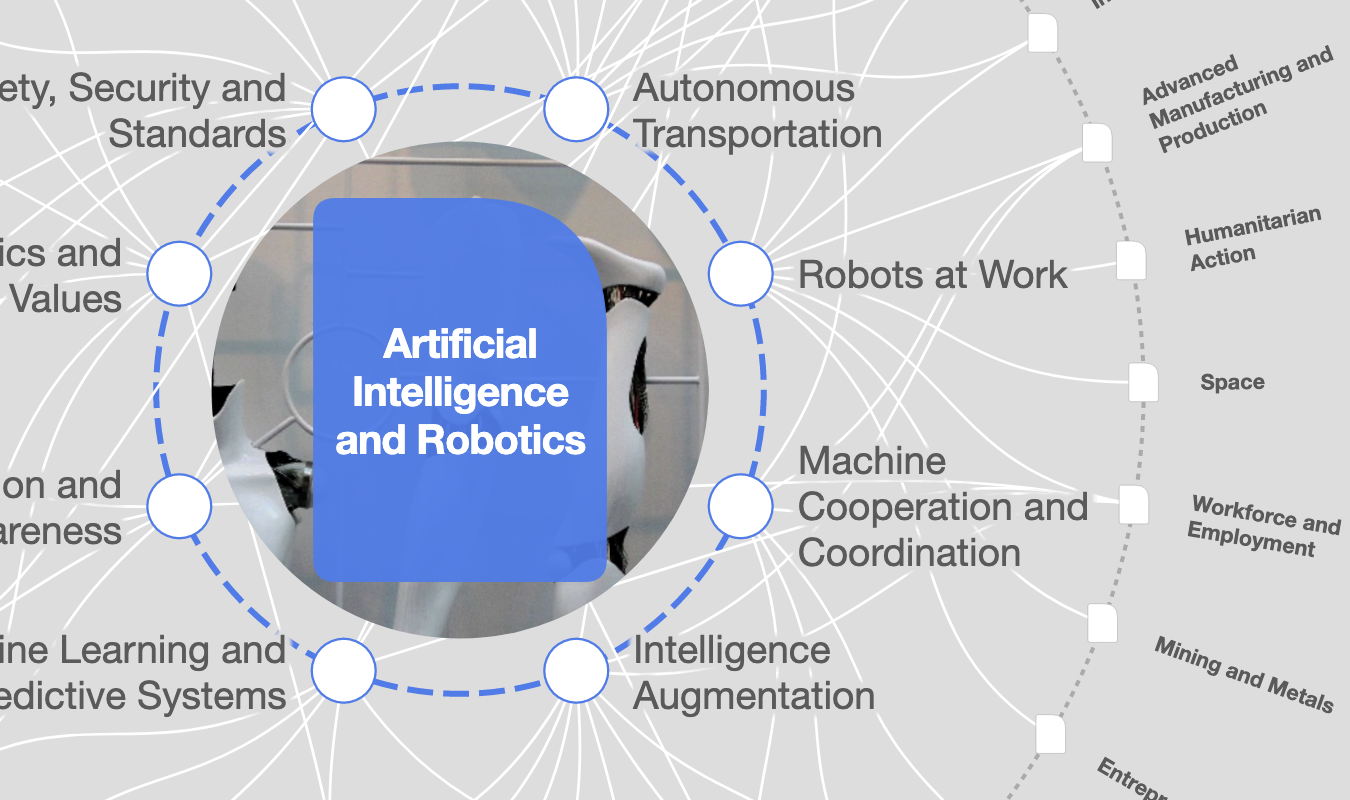

Varias voces influyentes ya han pedido que una organización australiana lidere la IA. El Foro Económico Mundial y la Comisión Australiana de Derechos Humanos formaron una sociedad para aprovechar este consenso emergente. Hoy, hemos invitado a los principales responsables de la toma de decisiones en el gobierno, la industria y el mundo académico a que se unan a nosotros en la University of Technology Sydney (UTS) para evaluar cómo abordaremos este desafío de liderazgo de la inteligencia artificial.

En una declaración conjunta, sugerimos que Australia necesita construir su estrategia de inteligencia artificial sobre tres pilares fundamentales. Primero, debemos expresar con claridad los valores que deben sustentar la inteligencia artificial en Australia: por excelencia, los valores de Australia, como la igualdad o el trato justo.

En segundo lugar, una organización australiana, ya sea nueva o existente, debería ocupar un papel central en la formulación de leyes, directrices, y estrategias de rendición de cuentas y fomento de capacidades en inteligencia artificial.

Tercero, esta organización debe trabajar estrechamente con la industria, el gobierno y la comunidad para apoyar el desarrollo de tecnologías de IA que respeten los derechos humanos.

En este momento, el Foro Económico Mundial y la Comisión Australiana de Derechos Humanos están celebrando consultas sobre estos temas, y han elaborado un informe, Inteligencia artificial: gobernanza y liderazgo, sobre el que estamos invitando a formular comentarios. Recibimos con satisfacción sus ideas y los amplios aportes de la comunidad en este proceso.

Nicholas Davis, jefe de Sociedad e Innovación, miembro del Comité Ejecutivo del Foro Económico Mundial

Edward Santow, comisionado para los Derechos Humanos, Comisión Australiana de Derechos Humanos

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

Macrodatos

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre Tecnologías emergentesVer todo

Inna Tokarev Sela

13 de noviembre de 2025