Todos quieren este caro chip para su IA. Pero, ¿qué es?

El microchip Nvidia H100 ha sido la piedra angular del mercado de la IA generativa. Image: Unsplash/vishnumaiea

- Entrenar inteligencia artificial (IA) generativa consume enormes cantidades de datos.

- Un chip ha acaparado el mercado con sus impresionantes capacidades de procesamiento, con la tecnología evolucionando a un ritmo exponencial.

- Pero desarrollar la IA de manera responsable sigue siendo una preocupación, como destacaron recientemente líderes en la Reunión Anual 2026 del Foro Económico Mundial.

Ha sido aclamado como el microchip que está impulsando el auge de la inteligencia artificial (IA). A 40,000 dólares, no es barato, pero incluso este potente chip ya está siendo superado por sucesores más avanzados. La Nvidia H100, presentada en 2022, es la unidad de procesamiento gráfico (GPU) que estableció el estándar y allanó el camino para la Blackwell B200 y la próxima arquitectura Rubin.

Crear aplicaciones de IA generativa es un negocio costoso, tanto en términos de dinero como en la cantidad de potencia de cálculo necesaria para entrenar la IA. De hecho, es tan exigente que solo un puñado de chips puede manejarlo, y a medida que el enfoque se desplaza hacia la “IA física” y la robótica, esa demanda sólo se está acelerando.

De alunizajes a IA generativa

Por supuesto, los microchips están por todas partes. La computadora portátil en la que estoy escribiendo esto y el dispositivo en el que lo estás leyendo no podrían funcionar sin ellos. Y, a medida que nuestras expectativas sobre lo que pueden hacer nuestros dispositivos se expanden, se han vuelto más poderosos.

Ya en 1965, Gordon Moore, uno de los fundadores del gigante tecnológico Intel, predijo que el número de transistores en un microchip –y por lo tanto su potencia de procesamiento– se duplicaría cada año. Esto se conoció como la Ley de Moore y los expertos dicen que todavía se cumple hoy.

No necesitas ser un experto en computadoras para apreciar el cambio en la potencia de procesamiento: los números hablan por sí mismos. La computadora que navegó las misiones espaciales Apollo tenía apenas 4 kilobytes (KB) de RAM y 72 KB de ROM, una fracción diminuta de los dispositivos modernos, pero suficiente para guiar a los astronautas a la Luna. La H100 tiene 80 gigabytes (GB), es decir, 80 mil millones de bytes. Mientras tanto, la más nueva Blackwell B200 cuenta con 192 GB. Este espacio extra es lo que permite que la IA pase de simples chatbots a una “IA Agente” que puede razonar a través de problemas de múltiples pasos.

La IA demanda procesadores cada vez más veloces

Por impresionante que sea, la H100 también forma parte de otra revolución en la potencia de las computadoras. La H100 es una GPU –una unidad de procesamiento gráfico– que, como su nombre lo sugiere, es un tipo de microprocesador desarrollado originalmente para generar gráficos en pantalla para juegos y videos.

De hecho, Nvidia creó la primera GPU en 1999. Desde entonces, su superior potencia de procesamiento ha hecho que las GPUs sean la opción predeterminada para manejar las enormes cantidades de datos necesarias para la IA.

La empresa controla hasta el 95 % del mercado de aceleradores, pero la naturaleza de este mercado ha cambiado. Operadores de centros de datos como Amazon (AWS), Google Cloud y Microsoft (Azure) ya no son solo clientes: ahora son competidores, desarrollando ASICs de IA personalizados (circuitos integrados de aplicación específica) como el Trainium de Amazon y la serie Maia de Microsoft para reducir la dependencia del silicio de terceros.

Mientras que la H100 era el estándar de la industria, fue el GH200 Grace Hopper Superchip —llamado así en honor a la pionera de la programación en Estados Unidos Grace Murray Hopper— el que cambió fundamentalmente las reglas al fusionar la CPU y la GPU en un único “cerebro” unificado con una enorme memoria compartida de 624 GB. Esta arquitectura allanó el camino para la actual Grace Blackwell B200, que ofrece 30 veces el rendimiento de la H100 en tareas de inferencia.

“Para satisfacer la creciente demanda de IA generativa, los centros de datos requieren plataformas de computación acelerada con necesidades especializadas”, dijo Jensen Huang, fundador y CEO de Nvidia, en el lanzamiento del GH200.

Hoy, ese legado continúa en la plataforma Rubin de la compañía, que se implementará a finales de 2026. Combinando seis nuevos chips, este sistema apunta a reducir los costos de IA por otro factor de diez, convirtiendo los centros de datos en “fábricas de IA” a gran escala capaces de IA Física –la ciencia de enseñar a las máquinas a interactuar con el mundo real.

También mejorará la eficiencia cinco veces, algo crucial cuando, como señaló recientemente Lisa Su, CEO de AMD, la IA está utilizando actualmente 100 zettaflops (operaciones de punto flotante de sextillones) frente a solo 1 zettaflop en 2022. “No tenemos ni remotamente suficiente capacidad de cómputo para todo lo que podemos hacer”, señaló.

Las generaciones futuras de chips y plataformas están siendo diseñadas para manejar estos conjuntos de datos en constante crecimiento, con enorme memoria y potencia de procesamiento que hacen que las cargas de trabajo avanzadas de IA sean factibles a gran escala.

Desarrollar IA responsable

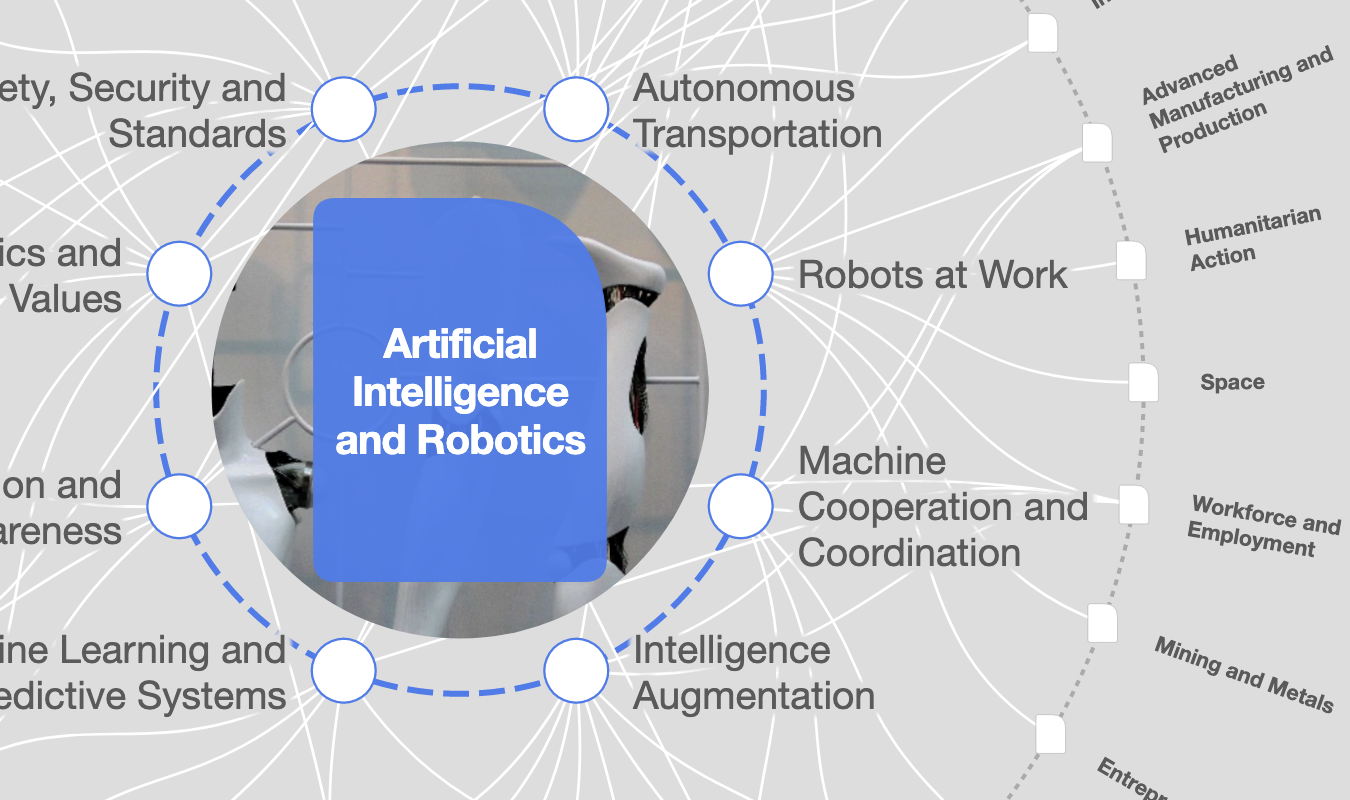

Pero el rápido ritmo de desarrollo ha dejado a muchos preocupados de que la regulación quede rezagada. El Foro Económico Mundial ha lanzado la AI Global Alliance, reuniendo a líderes de la industria, gobiernos, instituciones académicas y organizaciones de la sociedad civil, para promover el diseño y la liberación responsable de sistemas de IA transparentes e inclusivos a nivel global.

En abril de 2023, el Foro convocó “Responsible AI Leadership: A Global Summit on Generative AI” en San Francisco, al que asistieron más de 100 expertos técnicos y responsables de políticas. Juntos acordaron 30 recomendaciones para asegurar que la IA se desarrolle de manera responsable, abierta y al servicio del progreso social.

En las Historias del Foro, Cathy Li, jefa de IA, Datos y Metaverso en el Foro, y Jeremy Jurgens, director gerente del Foro, escribieron: “La IA generativa … está demostrando ser una fuerza transformadora en nuestras economías y sociedades.

“Su rápido desarrollo en los últimos meses subraya el papel vital de la IA como la infraestructura fundamental sobre la que evolucionará el panorama digital —y refuerza la necesidad de garantizar su uso responsable y ético.”

Un informe del Foro y Accenture de 2025 encontró que solo el 1 % de las organizaciones ha operacionalizado completamente la IA responsable, como se evidencia en el gráfico a continuación.

En enero de 2026, el enfoque del Foro evolucionó aún más para incluir la “IA soberana”. La inversión global en IA se está acelerando, y se espera que la inversión anual en infraestructura de IA aumente a 400 mil millones de dólares para 2030. Pero los países corren el riesgo de quedarse atrás a medida que la soberanía de la IA se confunde cada vez más con la propiedad de la infraestructura, según dice el documento técnico.

Huang, de Nvidia, coincidió durante una sesión destacada en Davos 2026 en que la IA ha “iniciado la mayor construcción de infraestructura en la historia de la humanidad”. Argumentó que debería estar al mismo nivel que otras infraestructuras, como la electricidad y las carreteras.

Huang instó a los países a crear sus propios modelos para procesar sus propios datos, en lugar de exportarlos, considerando los datos de una nación como su activo más valioso: “Con su experiencia local, deberían poder crear modelos que sean útiles para su propio país. Por eso realmente creo que cada país debería involucrarse, desarrollar infraestructura de IA, construir su propia IA, aprovechar su recurso natural fundamental, que es su idioma y cultura, desarrollar su IA, seguir refinándola, y que su inteligencia nacional sea parte de su ecosistema.”

Este movimiento hacia modelos soberanos y eficientes se considera ahora esencial para asegurar que los beneficios económicos del auge de la IA se compartan globalmente, en lugar de concentrarse en unos pocos centros tecnológicos.

Mira la sesión completa con Huang a continuación:

¿Qué está haciendo el Foro Económico Mundial en el ámbito de la cuarta revolución industrial?

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

AI for Scientific Discovery

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre Tecnologías emergentesVer todo

Sebastián Serrano

3 de marzo de 2026