Por qué el riesgo de pasar por alto la IA responsable ya no puede ser ignorado

Cualquier marco de IA debe construirse sobre una base que tenga en cuenta la propiedad intelectual y la trazabilidad de los datos. Image: REUTERS/Toby Melville

- Las empresas son conscientes de la necesidad de la IA responsable, pero muchas la tratan como un asunto secundario o un flujo de trabajo separado.

- La IA responsable es una defensa de primera línea frente a riesgos legales, financieros y reputacionales graves, especialmente en lo que respecta a comprender y explicar la trazabilidad de los datos de la IA.

- El escenario ideal es incorporar prácticas de datos confiables y la gestión de datos maestros desde el inicio.

Tu equipo de producto acaba de entregar una función innovadora desarrollada en tiempo récord. Con orgullo, describen cómo usaron un modelo de IA para acelerar la investigación y el diseño. Todos celebran el logro.

Mientras tanto, detrás de escena, ese mismo modelo podría haberse entrenado con datos propietarios que la empresa no posee. Peor aún, el equipo podría no saber qué datos utilizó el modelo y, aun si lo saben, tal vez no comprendan completamente ni estén al tanto de los términos y condiciones que rigen su uso.

Esa falta de claridad podría convertirse rápidamente en un riesgo legal. Lo que parecía innovación podría ahora desencadenar una demanda por propiedad intelectual que le cueste a la empresa mucho dinero y la confianza de sus clientes.

Este escenario no es descabellado. Con la rápida adopción de la IA en el ámbito empresarial y gubernamental, se trata de una advertencia sobre la creciente importancia de la IA responsable.

IA responsable y trazabilidad de datos

Muchas empresas son conscientes de la necesidad de la IA responsable. Pero muchas la tratan como un asunto secundario o un flujo de trabajo separado, algo que el equipo legal o de cumplimiento abordará después de que se construya un sistema.

Sin embargo, la IA responsable es mucho más que un proyecto paralelo o una nota al pie en una política de gobernanza. Es una defensa de primera línea frente a riesgos legales, financieros y reputacionales graves, especialmente cuando se trata de comprender y explicar la trazabilidad de los datos de la IA.

La mayoría de los modelos de lenguaje grande que se usan comúnmente, ya sean comerciales o de código abierto, se entrenan con una gran cantidad de datos, incluidos datos que son propietarios o restringidos a un uso particular. Los datos podrían haberse extraído de un sitio web corporativo, una revista académica, un repositorio de código abierto con una licencia restrictiva, un conjunto de datos gubernamentales o una plataforma de redes sociales que contenga datos personales.

El hecho de que estos modelos estén tan ampliamente disponibles por parte de proveedores importantes lleva a muchas empresas a asumir que su uso no implica ningún riesgo legal. Rara vez se detienen a preguntar, o incluso a pensar, de dónde provienen los datos dentro de los modelos o si tienen permiso legal para usarlos de la manera que pretenden.

Sin embargo, aunque el uso de la IA sea legal, los datos con los que se entrena muy a menudo no lo son. Cuando las empresas usan esos datos para diseñar un nuevo producto, generar contenido de marketing o construir una aplicación orientada al cliente, pueden exponerse sin saberlo a acciones legales, incluso mucho tiempo después de que su innovación impulsada por IA esté desplegada.

No es que los proveedores de modelos no incluyan advertencias legales; muchos lo hacen, e incluso las licencias de código abierto a menudo incluyen los términos y condiciones sobre el uso adecuado de sus datos y modelos. El problema es que las empresas a menudo no son conscientes de estas advertencias o pueden subestimar las consecuencias de no tomarlas en serio.

El hecho de que estas divulgaciones existan pone la responsabilidad directamente en manos de las empresas que usan los modelos. Como cualquier especialista en derecho te dirá, la ignorancia de la ley no es excusa. Desafortunadamente, muy pocas personas realmente las leen.

Una bomba de tiempo legal

No tengo muchas dudas de que los despachos legales de todo el mundo ya estén trabajando con expertos en IA para descubrir debilidades en el uso de datos de la IA. Estas debilidades podrían luego ser explotadas en litigios o demandas colectivas. Cualquier organización que no pueda explicar claramente la trazabilidad de sus datos o demostrar un uso responsable de los mismos podría estar en riesgo.

Una vez que se inicie la primera demanda, marcará el comienzo de una tendencia imparable. Ahora que la IA se usa de manera tan generalizada, las oportunidades para acciones legales son infinitas.

También es solo cuestión de tiempo antes de que veamos a los gobiernos imponer multas y sanciones para hacer cumplir el uso legal de los datos. La Ley de Inteligencia Artificial de la Unión Europea y el Marco de Gestión de Riesgos de IA de NIST ya requieren explicabilidad, trazabilidad de datos y uso ético. Así como hoy las auditorías de sostenibilidad son práctica habitual, mañana veremos que las auditorías de IA responsable se conviertan en algo rutinario.

Cómo evitar los riesgos de los datos de IA

Pero existen formas de evitar estos costosos errores. El escenario ideal es incorporar prácticas de datos confiables y la gestión de datos maestros desde el principio. Cualquier marco de IA debe construirse sobre una base sólida de IA responsable que considere la propiedad intelectual, la trazabilidad de los datos y la procedencia, no solo de los datos, sino también de los propios modelos de IA. Cuando estos principios se tratan como requisitos centrales de diseño en lugar de un aspecto secundario, las organizaciones pueden innovar con confianza mientras minimizan los riesgos legales y financieros.

En muchos casos, las empresas necesitarán evaluar de manera retroactiva los datos utilizados en sus sistemas de IA. Aquí es donde veremos surgir nuevos roles para mitigar riesgos. Los ingenieros de datos, por ejemplo, se convertirán en “podadores de datos”: personas específicamente capacitadas para identificar y eliminar datos no autorizados o de alto riesgo de los modelos. También veremos ingenieros de aseguramiento de calidad, capaces de validar los resultados de la IA, garantizar el cumplimiento de los estándares de IA responsable y rediseñar modelos para cumplir con los requisitos legales y funcionales.

Una vez que se eliminen los datos no conformes o no autorizados, muchas empresas recurrirán a los datos sintéticos como una alternativa más segura, lo que les permitirá reentrenar modelos sin comprometer la integridad de la propiedad intelectual ni el cumplimiento normativo.

En última instancia, podríamos ver a las empresas pasar de modelos de propósito general a sistemas de IA personalizados construidos sobre datos limpios y propios. Esta transición reducirá significativamente la dependencia de modelos genéricos. Al invertir en modelos personalizados, las organizaciones obtendrán un mayor control, transparencia y confianza legal en el funcionamiento de su IA.

Avanzar con confianza en la IA

A medida que la IA evoluciona, respetar la trazabilidad de los datos y la propiedad intelectual se volverá crucial para demostrar compromiso con la IA responsable. Pero más allá de ser un buen ciudadano corporativo, las empresas también deberán considerar la IA responsable como un cortafuegos entre la innovación y los costosos riesgos legales y financieros.

Las organizaciones que construyan siguiendo los principios de IA responsable desde el inicio no solo se mantendrán protegidas; también estarán en condiciones de avanzar con confianza para desbloquear valor a largo plazo.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

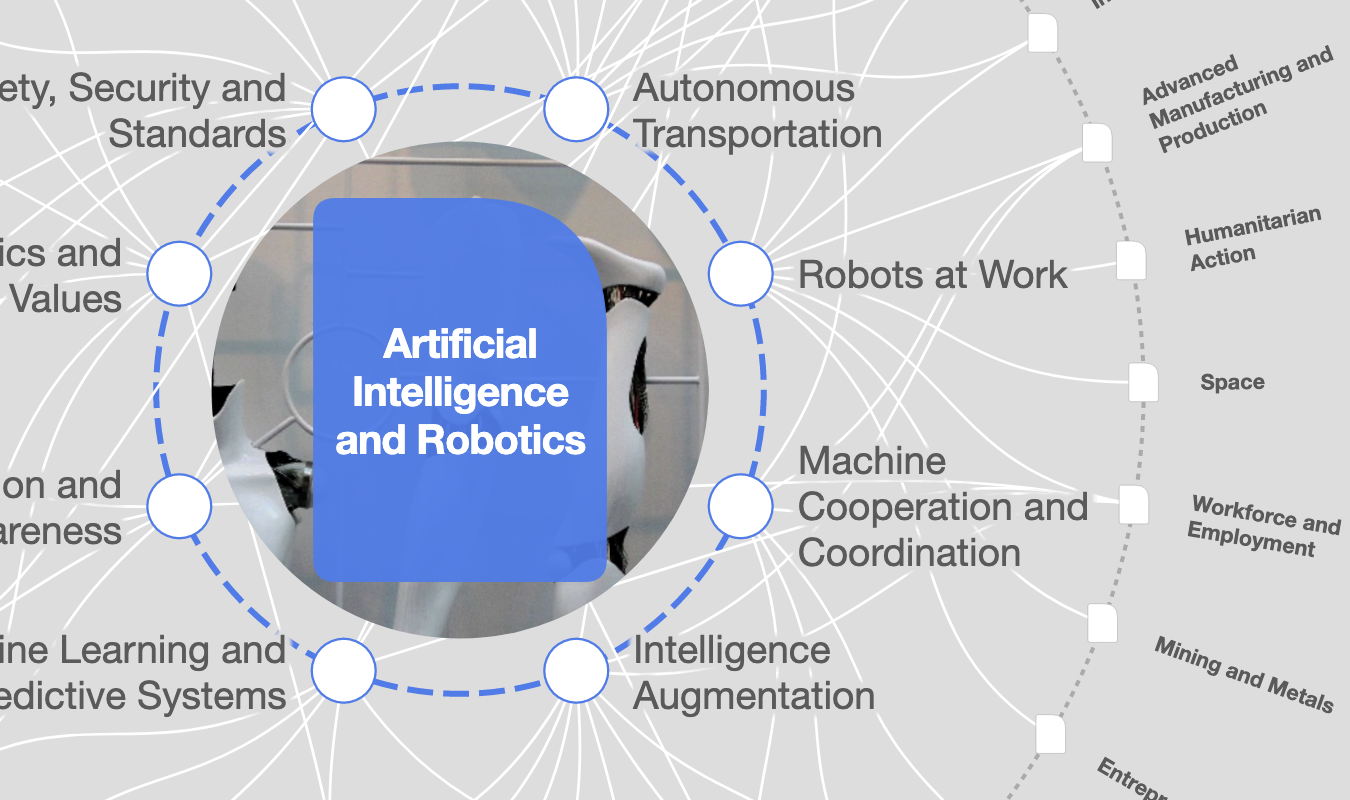

Inteligencia Artificial y Robótica

Temas relacionados:

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre NegociosVer todo

Natalya Guseva and Haleh Nazeri

11 de febrero de 2026