Cómo la inteligencia emocional es la mejor defensa contra las amenazas de la IA generativa

El primer paso para mitigar las amenazas de la IA generativa es la educación. Image: Unsplash/Thom Holmes

- La inteligencia emocional es esencial para reconocer y gestionar la manipulación mediante inteligencia artificial (IA), especialmente cuando se trata de estafas.

- Las organizaciones deben formar a sus empleados para detectar los desencadenantes emocionales y practicar la reflexión para mitigar las amenazas de la IA generativa (GenAI).

- Fomentar la reflexión frente a las reacciones impulsivas puede ayudar a prevenir la explotación de la IA en la toma de decisiones.

Imagine recibir una llamada angustiada de su nieto; su voz llena de miedo mientras le describe un horrible accidente de coche. Eso es lo que le ocurrió a Jane, una señora de 75 años de Regina (Canadá).

Presionada por la urgencia, en pocas horas estaba en el banco, retirando el dinero de la fianza para su nieto. Sólo más tarde descubrió que había sido víctima de una estafa generada por IA.

Para 2030, se espera que la inteligencia artificial generativa (GenAI) automatice el 70% de las operaciones empresariales mundiales, lo que entusiasma y fascina a los directivos. Pero hay un lado más oscuro de la GenAI: la utilización como arma de engaño a las personas.

La historia de Jane no es un hecho aislado. Las estafas de manipulación emocional también suponen una grave amenaza para las empresas, exponiéndolas a riesgos financieros y de reputación.

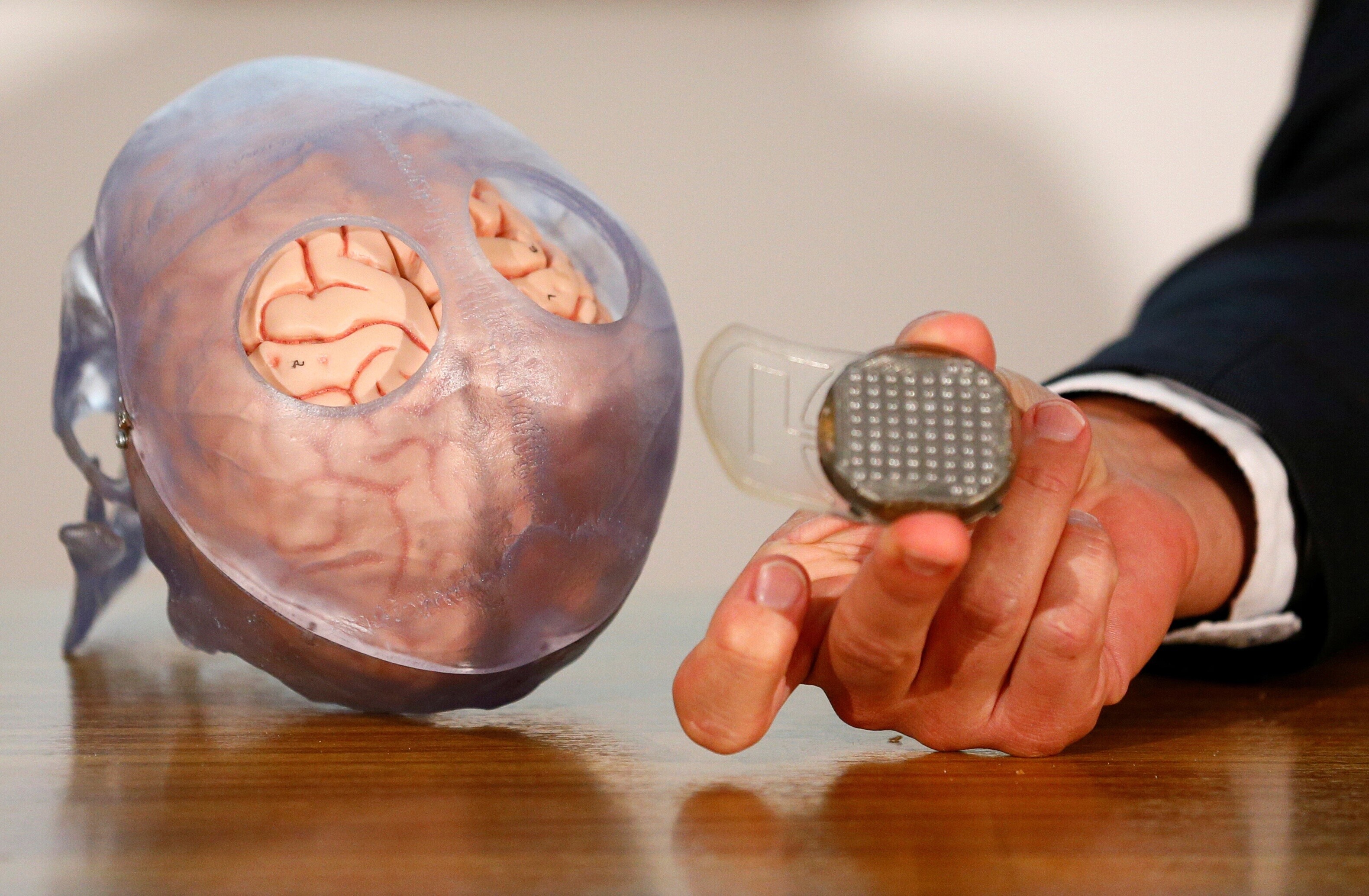

Datos recientes indican que uno de cada 10 ejecutivos ya se ha topado con una amenaza de deepfake -una tecnología de IA entrenada con material de vídeo y audio real-, y que el 25% de los líderes aún no está familiarizado con sus riesgos.

Detectar contenidos generados por IA sigue siendo una lucha. Para verificar los contenidos digitales, primero pedimos ayuda a la tecnología. Aunque muchas herramientas presumen de su capacidad para detectar contenidos generados por IA, su precisión es desigual.

Estamos lejos del éxito del etiquetado automático de los contenidos generados por IA, especialmente haciendo referencia a herramientas que pueden eludir la detección, como la eliminación de marcas de agua de IA de las imágenes.

Y a pesar de algunas herramientas prometedoras, como FakeCatcher de Intel, su implementación a gran escala sigue ausente. Mientras las organizaciones se ponen al día con la GenAI, el escepticismo humano sigue siendo nuestra mejor protección.

La inteligencia emocional -reconocimiento, comprensión y gestión de las propias emociones- es una ventaja para identificar la manipulación posibilitada por la IA.

La GenAI presenta tres riesgos clave que la inteligencia emocional puede ayudar a resolver:

- El resultado hiperrealista de GenAI se convierte en la herramienta de un estafador para explotar respuestas emocionales, como la urgencia o la compasión.

- Las trampas éticas de GenAI son a menudo involuntarias, ya que los empleados pueden seguir por defecto las recomendaciones de la IA o caer en el sesgo de la automatización, priorizando la eficiencia sobre la ética.

- Desde la ansiedad laboral hasta la indiferencia ética, los empleados pueden tomar decisiones impulsivas bajo la tensión emocional de la GenAI.

Ante el avance de las amenazas de la GenAI, la inteligencia emocional es clave

Para gestionar el impacto de las amenazas de GenAI, las personas deben reconocer las emociones en juego, reflexionar sobre las implicaciones y responder con acciones informadas y empáticas. Aquí hay tres maneras de hacer esto.

1. Ayudar al equipo de trabajo a reconocer cuándo las emociones convertidas en armas

La investigación sugiere que el comportamiento humano causa el 74% de las violaciones de datos, y no es difícil ver por qué.

GenAI puede personalizar las estafas con solo analizar los datos de los empleados o el contenido específico de la empresa. Los actores de amenazas pueden incluso aprovechar su huella digital para crear un vídeo deepfake de usted.

Todo lo que se necesita son menos de ocho minutos y un costo insignificante. En este contexto, el primer paso para mitigar las amenazas de GenAI es la educación.

Los empleados tienen que entender cómo la inteligencia artificial generativa puede aprovechar las emociones para imponerse por sobre las decisiones racionales. Un alto directivo de una empresa de ciberseguridad compartió con nosotros una experiencia reveladora.

Recientemente, recibió un mensaje de WhatsApp y una grabación de voz de un estafador que se hacía pasar por su CEO, discutiendo detalles legítimos sobre un acuerdo comercial urgente.

La presión emocional de una autoridad superior provocó inicialmente una reacción. Sin embargo, el conocimiento de las normas de comunicación de la organización por parte del impostor ayudó a detectar las señales de alarma: que los canales informales no deben utilizarse para datos sensibles y llamadas de supervisión.

Los directivos deben invertir en formación que potencie la inteligencia emocional. Los talleres centrados en la identificación de los desencadenantes emocionales, combinados con simulaciones -centradas en el pensamiento creativo y las estrategias flexibles más allá del estricto cumplimiento de las normas- ayudan a los empleados a detectar antes la manipulación.

2. Haga de la reflexión un hábito en su equipo

Los individuos también deben considerar cómo sus acciones, impulsadas por las emociones, pueden tener consecuencias imprevistas. La reflexión nos permite considerar cómo nuestras emociones pueden afectar inconscientemente a nuestro comportamiento.

Un ejemplo reciente de ausencia de supervisión moral es el de una revista alemana que publicó una entrevista generada por inteligencia artificial a Michael Schumacher, leyenda de la Fórmula 1, sin su consentimiento. La entrevista incluía citas falsas sobre su estado de salud y su vida familiar desde 2013.

Impulsados por la emoción de publicar una "primicia", los periodistas no reflexionaron sobre su impacto emocional en Schumacher y su familia. El resultado fue un importante daño a la reputación de la revista.

La reflexión crítica en el trabajo nos anima a considerar diferentes perspectivas y factores que influyen en nuestras decisiones.

Los líderes pueden facilitarla introduciendo ejercicios de reflexión en grupo.

Un buen ejemplo es la técnica de la "mosca en la pared", en la que un miembro del equipo presenta un resultado de GenAI y luego observa en silencio cómo los demás discuten sus consideraciones éticas y sesgos.

Por último, se comparten las conclusiones del debate. Tras esta reflexión, las situaciones familiares pueden adquirir nuevos significados, revelar suposiciones subyacentes y advertir sobre la confianza en la IA.

3. Convertir las reacciones rápidas en respuestas meditadas

El último paso consiste en traducir la concienciación y la reflexión en acciones deliberadas. Incluso al considerar los riesgos, la "influencia de la IA" puede anular el buen juicio. Dele a sus empleados la autoridad de establecer límites para recuperar el control de los procesos de toma de decisiones.

Animarles a comunicar su malestar o a retrasar la acción hasta la verificación, como decir: "Necesito confirmación por escrito antes de proceder", puede frenar el impulso manipulador.

Este tipo de respuestas son posibles gracias a una cultura de diálogo abierto, en la que se anima a los empleados a cuestionar las instrucciones o expresar sus preocupaciones sin miedo.

Un ejemplo reciente es el de un ejecutivo de Ferrari que recibió una llamada del CEO, Benedetto Vigna. Al principio, parecía verosímil. Pero cuando la conversación se volvió confidencial, el ejecutivo empezó a dudar.

No dispuesto a arriesgarse, hizo una pregunta que sólo el verdadero CEO podía responder. El interlocutor colgó bruscamente, revelando su estafa. Actualmente asistimos a un aumento de la probabilidad de "enredo emocional" por exceso de confianza, antropomorfización y difuminación de los límites entre ficción y realidad.

Ser presa de nuestras emociones sólo nos hace humanos. Sin embargo, también es posible regularlas para tomar mejores decisiones. En última instancia, un mundo automatizado puede beneficiarse de la sensibilidad de estas estrategias.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

Ciberseguridad

Temas relacionados:

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre CiberseguridadVer todo

Christophe Blassiau, Michael Daniel and Michele Mosca

31 de octubre de 2025