Generar confianza en la IA significa ir más allá de los algoritmos ocultos. ¿Por qué?

Los algoritmos ejercen una influencia cada vez mayor en el mundo. Debemos comprender y controlar mejor sus resultados. Image: Getty Images/iStockphoto

- Generar confianza en la IA, sobre todo en contextos de alto riesgo como la medicina, implica comprender cómo y por qué los algoritmos toman determinadas decisiones.

- Pero en la era de la IA moderna, estos algoritmos son con demasiada frecuencia "cajas negras": ni siquiera sus creadores entienden del todo por qué producen determinados resultados.

- Para introducir la IA en entornos de alto riesgo como la salud pública, debemos utilizar algoritmos interpretables y libres de prejuicios.

Los algoritmos están en todas partes. Los algoritmos son parte integral de nuestras vidas, y lo son desde hace mucho tiempo. Su omnipresencia no es un fenómeno reciente; los algoritmos, como una serie de instrucciones, han desempeñado un papel clave en la obtención de resultados durante siglos.

Esto es especialmente cierto en la era actual, en la que tecnologías como la Inteligencia Artificial (IA) están entretejiendo algoritmos en el entramado de cada aspecto de nuestra vida cotidiana.

Dado que los algoritmos dan forma a nuestra existencia, es imperativo generar confianza en ellos. Los sistemas de IA, por ejemplo, solían ser algoritmos relativamente simples. Estas piezas de software bastante rudimentarias eran capaces de hacer algunas estimaciones aproximadas, aprendiendo de los datos que se les proporcionaban para identificar principalmente patrones. Estos precursores de la IA más avanzada que vemos hoy en día a menudo se siguen utilizando en aplicaciones menos evolucionadas, como la previsión de ventas o la puntuación de riesgos.

En la última década, sin embargo, hemos visto cómo la IA mejoraba hasta alcanzar niveles con los que sólo podíamos soñar.

Algoritmos de caja negra

La IA de última generación, como la que hay detrás del ChatGPT de OpenAI, se ha vuelto extremadamente potente, capaz de generar textos, imágenes y ahora vídeos que a menudo compiten con escritores, diseñadores y videastas expertos. Pero eso tiene un alto precio. Aunque los modelos antiguos son menos precisos, son mucho más interpretables y, por ello, más fiables, en parte por su simplicidad, que los llamados modelos de "caja negra" que impulsan la mayor parte de la IA actual.

La complejidad de la IA moderna la hace muy eficaz en escenarios de bajo riesgo, pero casi imposible confiar en ella en escenarios de alto riesgo, como la salud, la justicia penal y las finanzas, entre otros. Como dijo el fundador de OpenAI, Sam Altman, durante la reunión anual del Foro Económico Mundial de este año, "el tipo de IA de OpenAI es buena en algunas cosas, pero no es tan buena en situaciones de vida o muerte".

Por eso, no podremos confiar en estos modelos para que nos proporcionen información sobre áreas críticas y delicadas hasta que seamos capaces de confiar plenamente en ellos. Tenemos que recuperar la confianza no sólo entre nosotros, sino también en las máquinas. No es una tarea fácil pero, con la suficiente cooperación, está al alcance de la mano.

Explicación: Más allá de los algoritmos de caja negra

Uno de los primeros pasos consiste en desarrollar y defender sistemas de IA que sean "interpretables". Con las arquitecturas actuales de los grandes modelos lingüísticos, como ChatGPT, no podemos echar un vistazo al interior de estos algoritmos. No podemos entender el proceso de toma de decisiones que ha llevado a la IA a dar una respuesta o recomendación específica. Esto plantea problemas importantes en situaciones de alto riesgo. En el sector sanitario, necesitamos entender por qué el modelo ha diagnosticado a un paciente una enfermedad concreta. Necesitamos comprender las consideraciones que subyacen a dicho diagnóstico. El médico que revise la salida del algoritmo debe poder verificar que el modelo ha llegado a una conclusión que sigue el planteamiento del médico. En general, debemos ser capaces de preguntar a la IA "por qué" ha llegado a esas conclusiones y comprender el proceso lógico que ha seguido, especialmente en aplicaciones sensibles. Inspeccionando el flujo, podríamos descubrir fallos en el proceso de pensamiento, lo que comúnmente se denomina "alucinaciones".

Eliminación de tendencias: Integrar la equidad en las decisiones algorítmicas

La explicación de los modelos es sólo una parte de la búsqueda de una IA en la que podamos confiar. Dado que los sistemas de IA son tan buenos como los datos que utilizan, es fundamental que nos aseguremos que los datos utilizados para entrenar esos modelos sean de la máxima calidad. Esto significa utilizar fuentes de datos confiables que puedan proporcionar información precisa y objetiva. Sin embargo, no siempre es fácil obtener esa información en situaciones reales.

La mayoría de los datos y la información que nosotros y los algoritmos digerimos en formato digital están sujetos a diversas limitaciones. Por esta razón, los sistemas de IA tienden a mostrar parcialidades, no por comportamientos maliciosos innatos, sino más bien porque han sido entrenados con información históricamente sesgada. Esto resulta potencialmente perjudicial en escenarios de alto riesgo. Por ejemplo, un hipotético sistema de IA que predijera la probabilidad de reincidencia de una persona podría discriminar por motivos de etnia, sexo u otros atributos protegidos. Hay varias técnicas que pueden utilizarse para mitigar, e idealmente eliminar, el prejuicio. Como usuarios, debemos saber que existe esa posibilidad y hacer preguntas a los creadores de algoritmos para asegurarnos de que disponen de salvaguardias para evitar la discriminación.

Marco político: Un enfoque unificado de la IA

Por último, necesitamos establecer un marco común que proporcione orientaciones compartidas sobre el desarrollo de la IA. Dado que la IA está en pañales, aún carecemos de un marco unificado que defina las mejores prácticas y los requisitos de los sistemas de IA. Esto provoca fragmentación. Los agentes privados y públicos tienen que elegir sus propias directrices, o la falta de ellas, lo que provoca que sistemas potencialmente dañinos sean utilizados por la población en general.

Como dijo el profesor Luciano Floridi, Director del Centro de Ética Digital de la Universidad de Yale, en una entrevista reciente: "Debemos diseñar una sociedad en la que todos ganen, en la que los operadores tecnológicos puedan tener un impacto positivo en los mercados, la sociedad y el medio ambiente". Para ello, debemos garantizar la coherencia y una orientación compartida, haciendo que los gobiernos y las organizaciones internacionales intervengan para crear marcos que sean de aplicación general en todos los países e industrias, garantizando la regulación sin ahogar la innovación.

Como usuarios de estos algoritmos, tenemos el deber de abogar por una IA equitativa y responsable en la que podamos confiar. Como organizaciones implicadas en el desarrollo y la regulación de estos sistemas, tenemos que fomentar la cooperación público-privada entre las distintas partes interesadas para aprovechar una amplia gama de conocimientos.

Solo reuniendo en la misma mesa a expertos, responsables políticos y usuarios podremos garantizar realmente el éxito en la recuperación de la confianza en los sistemas de IA que desempeñan un papel fundamental incluso en escenarios de alto riesgo, garantizando la cooperación entre humanos y máquinas hacia una sociedad mejor.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

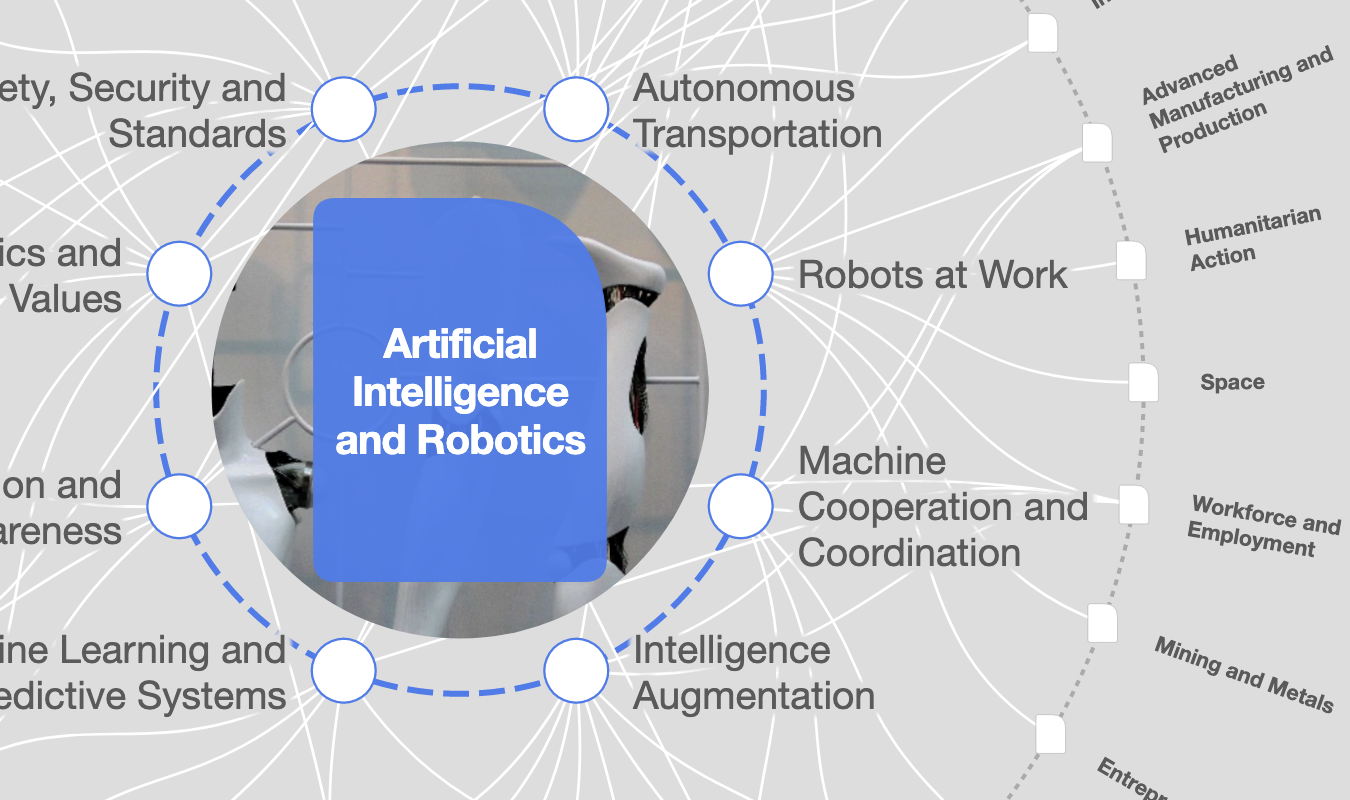

Inteligencia Artificial y Robótica

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre Tecnologías emergentesVer todo

Inna Tokarev Sela

13 de noviembre de 2025