IA: ¿Se pondrá la gobernanza a la altura de la tecnología en 2024?

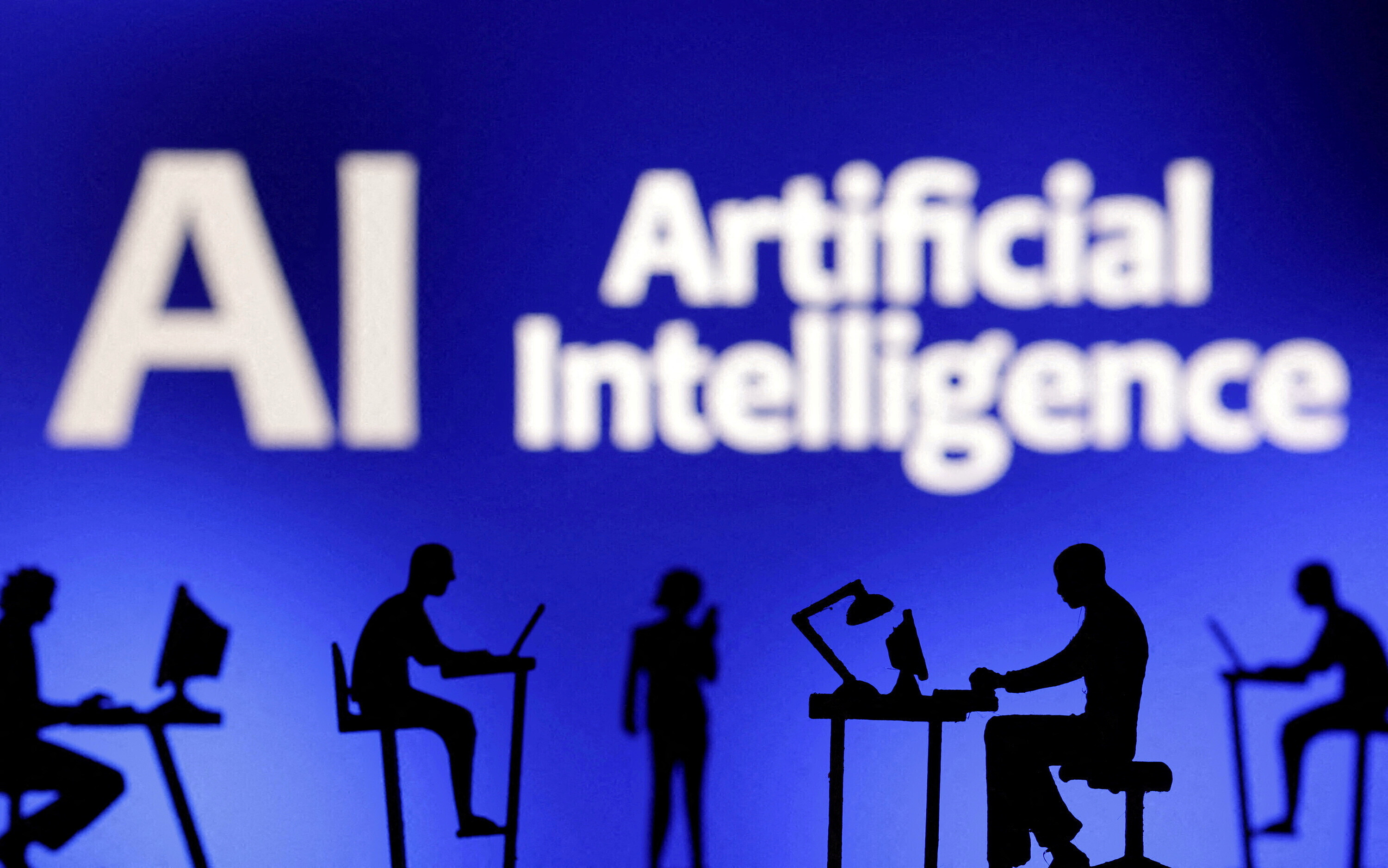

La gobernanza de la IA es cada vez más importante a medida que se vuelve más compleja. Image: Unsplash/Ilya Pavlov

- La inteligencia artificial sigue avanzando a gran velocidad en 2024.

- Los tomadores de decision están tomando nota, pero ¿habrá este año grandes avances en la gobernanza de la IA?

- Tres expertos del sector opinan en en más reciente episodio del podcast Radio Davos del Foro Económico Mundial.

Si 2023 fue el año en que el mundo se familiarizó con la IA generativa, ¿será 2024 el año en que los gobiernos actuarán en serio sobre su gobernanza?

Esta es la pregunta planteada a los invitados del último episodio del podcast Radio Davos, del Foro Económico Mundial. El presente artículo se basa en conversaciones grabadas en Davos 2024 con:

- Alexandra Reeve Givens, CEO de la organización sin ánimo de lucro Center for Democracy & Technology;

- Aidan Gomez, cofundador y CEO de la empresa de inteligencia artificial Cohere;

- y Anna Makanju, Vicepresidenta de Asuntos Globales de OpenAI, que crea productos de IA entre los que se incluye ChatGPT.

A continuación, le presentamos algunas de sus opiniones - en el podcast, podrá escuchar las conversaciones completas.

El impulso a la gobernanza de la IA

El Índice de IA de la Universidad de Stanford muestra que el interés de los responsables políticos por la IA va en aumento. En 127 países, el número de proyectos de ley que hacen referencia a la inteligencia artificial ha pasado de uno en 2016 a 37 en 2022. Asimismo, la Unión Europea está preparando su Ley de Inteligencia Artificial, a la que denomina la primera ley integral de inteligencia artificial del mundo.

Aidan Gómez, de Cohere, está de acuerdo en que la gobernanza es necesaria, pero subraya que "la forma en que llegamos a ella es increíblemente importante".

"Es difícil regular una tecnología horizontal como el lenguaje. Afecta a todos los ejes verticales, a todos los sectores: dondequiera que haya más de un ser humano, hay lenguaje.

"Deberíamos regularla en un nivel vertical y ayudar a los responsables políticos existentes, a los reguladores existentes, a obtener conocimientos sobre la IA generativa y su impacto en su campo de experiencia. Esto les ayudará a mitigar los riesgos en su contexto".

Gómez añade que, cuando se trata de regulación mundial, es necesario el consenso y la coordinación internacionales. Además, toda regulación debe potenciar la innovación en lugar de reprimirla, especialmente la de las empresas más pequeñas.

"La IA es una tecnología tan poderosa que creo que tenemos que proteger al pequeño. Tiene que haber nuevas ideas. Tiene que haber una nueva generación de pensadores que construyan y contribuyan. Y eso tiene que ser una prioridad máxima para los reguladores".

La normativa pasa a la 'fase de acción'

Sin embargo, a medida que la IA sigue avanzando, también lo hace el potencial de uso indebido de la tecnología. Con más de 2000 millones de votantes en todo el mundo acudiendo a las urnas en 2024, cada vez se presta más atención a riesgos como la desinformación y los deepfakes que amenazan con disrumpir el proceso democrático.

Muchas de las mayores empresas de IA han firmado el Acuerdo Tecnológico para Combatir el Uso Engañoso de la IA en las Elecciones de 2024, un conjunto de compromisos para combatir la falsificación de imágenes, vídeos y audios de candidatos.

Pero hacer frente a los deepfakes es sólo una parte del rompecabezas inmediato, según Alexandra Reeve Givens, de la ONG Center for Democracy & Technology. A largo plazo, afirma, será importante considerar el papel que desempeña la desigualdad económica en la supervivencia de la democracia.

"En términos de IA, eso plantea cuestiones no sólo de desplazamiento de puestos de trabajo", añade, "sino también de cómo se toman las decisiones sobre quiénes pueden acceder a un préstamo, a quién se elige para un puesto de trabajo, si a alguien se le aprueban o no las prestaciones públicas".

"La IA se está filtrando en todos esos sistemas de formas a las que los responsables políticos y las empresas tienen que prestar atención".

Las empresas, los gobiernos y la sociedad civil ya están debatiendo cómo abordar estas cuestiones y, para Givens, 2024 es el año en que deben "pasar a la fase de acción".

"Tenemos que pasar de los debates de alto nivel a la redacción de leyes, la adopción de políticas y la aplicación de nuevos diseños por parte de las empresas.

"Una gran división en 2023 era si nos centrábamos o no en los riesgos a largo plazo o en los riesgos a corto plazo. Me gustaría pensar que ahora hemos alcanzado el modelo de madurez, con gente que se da cuenta de que podemos y debemos hacer ambas cosas a la vez."

Creando un diálogo común

Anna Makanju, de OpenAI, defiende un consenso internacional sobre el "riesgo catastrófico" asociado a la IA y la autorregulación dentro de las empresas.

Red-teaming, por ejemplo, es una práctica común en la industria, dice. Se trata de un proceso utilizado en el desarrollo de software y ciberseguridad para analizar los riesgos y evaluar las capacidades dañinas de los nuevos sistemas.

"Esto es algo que hemos hecho con nuestros modelos para asegurarnos de que podemos entender cuáles serán algunos de los riesgos inmediatos: ¿cómo puede usarse mal? ¿Cómo podemos mitigar esos riesgos?".

Para compartir conocimientos y experiencia en seguridad, cuatro de las mayores empresas de IA han creado el Frontier Model Forum (Foro de Modelos Fronterizos). A través de este foro, Anthropic, Google, Microsoft y OpenAI se han comprometido a avanzar en la investigación de la seguridad de la IA y a forjar colaboraciones público-privadas para garantizar un desarrollo responsable de la tecnología.

"Se trata de identificar un conjunto común de prácticas", afirma Makanju, quien añade que este trabajo también alimenta la normativa al ayudar a determinar dónde deben fijarse los parámetros. "Al fin y al cabo, las empresas que construyen estos modelos son las que más saben de ellos. Son las que mejor conocen todos los aspectos. Y no creo que nadie deba confiar en que las empresas se autorregulen. Pero creo que es necesario mantener este diálogo, tener una regulación que sea realmente sólida".

La Alianza para la Gobernanza de la IA, del Foro Económico Mundial, ofrece un espacio para que los líderes del sector, los gobiernos, las instituciones académicas y las organizaciones de la sociedad civil aborden abiertamente las cuestiones relacionadas con la IA generativa para ayudar a garantizar el diseño y el suministro de sistemas de IA responsables.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

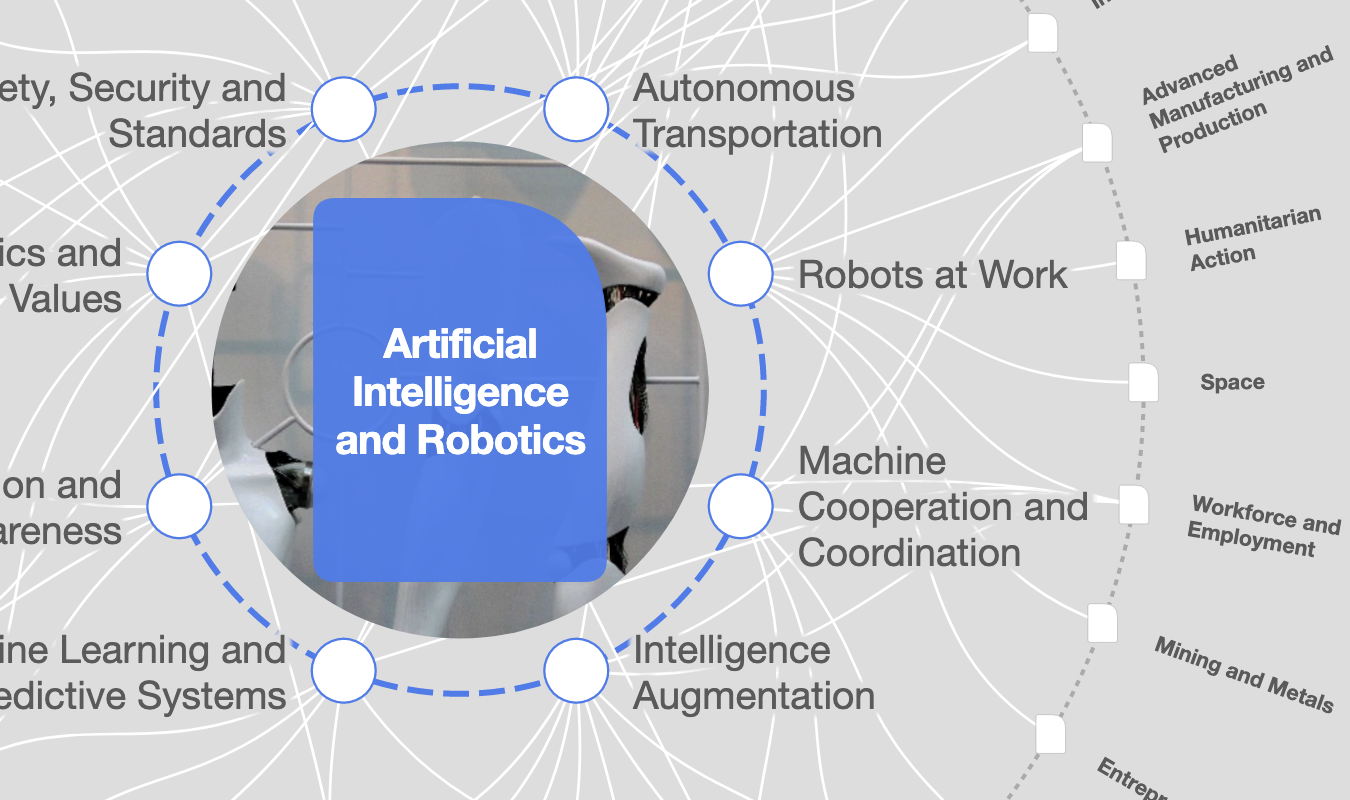

Inteligencia Artificial y Robótica

Temas relacionados:

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre Tecnologías emergentesVer todo

Inna Tokarev Sela

13 de noviembre de 2025