¿Eres un ‘troll’? Twitter ya sabe cómo identificarte antes de que actúes

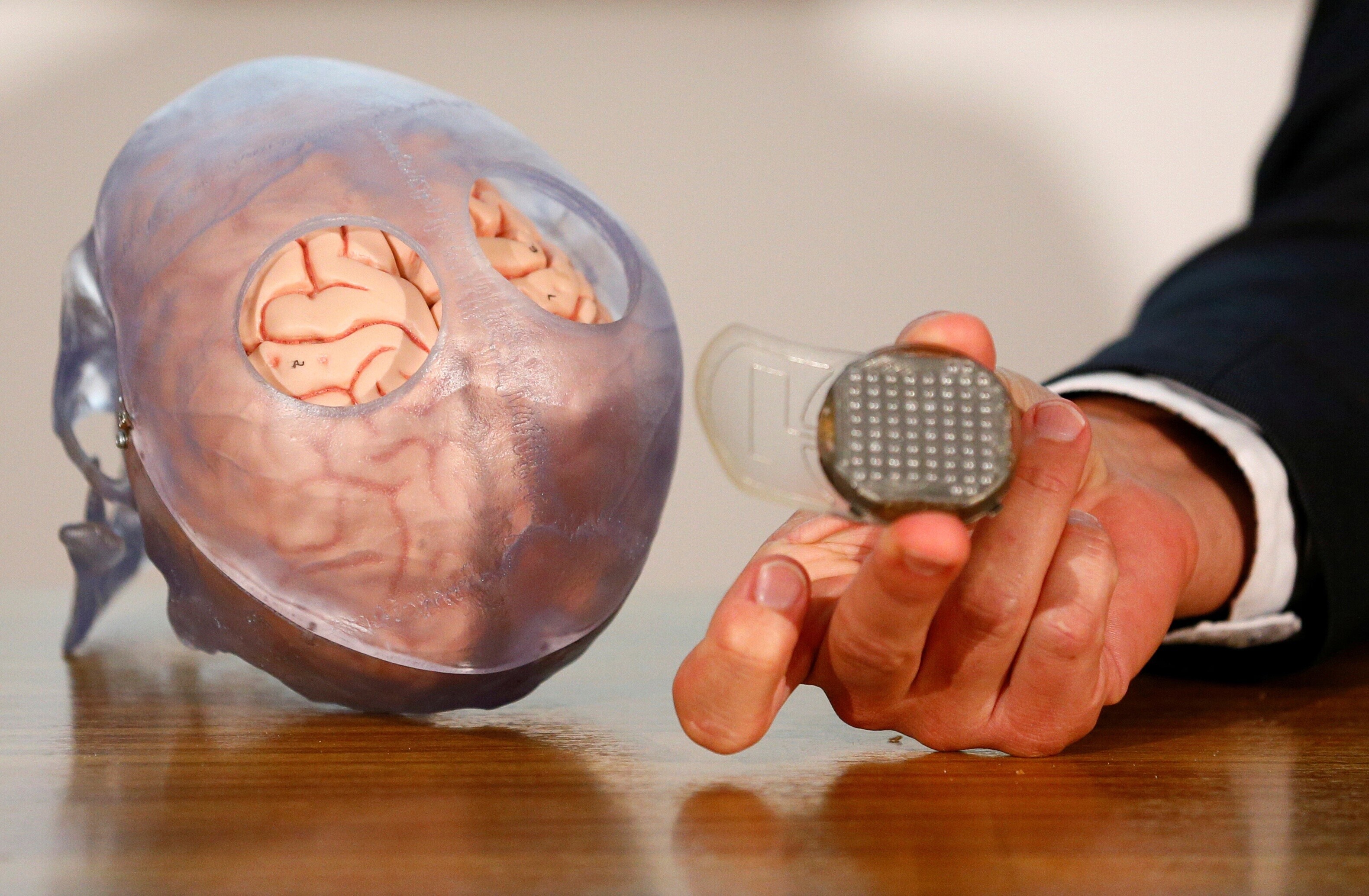

Image: REUTERS/Wolfgang Rattay

Tu comportamiento en Twitter te delata, incluso antes de tuitear. Si eres un troll y tu intención es vapulear y enfurecer a los usuarios o simplemente conseguir más tráfico para tu web de venta de camisetas, a partir de ahora lo tendrás más complicado. O, al menos, eso dice Twitter. Esa es la nueva estrategia anunciada hoy por la plataforma de Jack Dorsey: gracias a una nueva tecnología que identifica el comportamiento de los spammers, Twitter los sacará de la conversación sin la necesidad de esperar a que otras personas usuarias les denuncien.

“Hay comportamientos que no incumplen nuestras reglas pero que desvirtúan la conversación”, explica por telefono David Gasca, director de Gestión de Producto de Twitter. No pueden eliminar esas cuentas, pero sí relegarlas a un segundo plano y hacer que no aparezcan en las búsquedas ni en las conversaciones. Desde el pasado marzo, cuando la tecnológica -que tiene 330 millones de usuarios en todo el mundo- anunció que dedicaría todos sus esfuerzos a mejorar la calidad y la “salud” de los diálogos en Twitter, cerca del 1% de las cuentas (unos 3,3 millones) han recibido denuncias por abusos. Sin embargo, muchos de esos avatares no incumplen las reglas de juego ni violan sus políticas.

¿Qué considera Twitter un comportamiento inapropiado? David Gasca pone un ejemplo. “Vas al buscador e introduces World Cup Game. Te aparecen un puñado de tuits sobre ese contenido y en la parte inferior un enlace con el que alguien pretende vender una camiseta. No tiene nada que ver con el torneo, pero está usando el hashtag #WorldCup. La cuenta se creó una hora antes y los likes que acumula son de cuentas que también se crearon una hora antes”.

Los trolls “distraen de la conversación en Twitter, la embrutecen, tergiversan y distorsionan”, aseguran desde la compañía. ¿Cómo se les identifica incluso antes de que actúen? Gracias al machine learning (una rama de la inteligencia artificial que permite a las máquinas aprender de forma automática) y a la revisión de comportamientos humanos, la compañía analiza cómo se presentan los tuits en los diálogos y en las búsquedas. A su vez, con esa tecnología catalogan los patrones de comportamiento.

Hay varios indicios que pueden delatar a un troll. Por ejemplo, si una cuenta no ha confirmado su correo electrónico; si una misma persona se registra con diferentes cuentas al mismo tiempo; cuentas que tuitean permanentemente y que mencionan a otros usuarios que no les siguen, o comportamientos que podrían indicar un ataque coordinado. También analizan cómo ciertas cuentas están conectadas con otras que sí violan las reglas de Twitter y cómo interactúan con ellas.

“El resultado es claro: las personas que contribuyan a una conversación más saludable tendrán mayor visibilidad tanto en las conversaciones como en las búsquedas”, explican desde Twitter. En sus primeras pruebas para testear ese modelo en diferentes partes del mundo, han registrado un descenso del 8% en las denuncias de abuso en las conversaciones y un 4% en las búsquedas. Sin embargo, la compañía no específica el número total de denuncias se registran al año. “Menos personas están viendo tuits que distorsionan su experiencia en Twitter”, cuenta Del Harvey, vicepresidenta de Seguridad de Twitter.

Las cuentas que “molestan”, pero que no incumplen sus normas, seguirán en la plataforma y estarán disponibles siempre que el usuario teclee ‘mostrar más respuestas’ o si configura en su ajuste de búsquedas que se le muestre todo.

Dentro de su línea de castigo a los usuarios incómodos, desde el pasado noviembre Twitter ha empezado a eliminar la verificación de cuentas a usuarios con comportamientos extremos. La insignia azul de verificación fue originalmente diseñada para confirmar la identidad de un usuario, pero se interpreta como el respaldo de Twitter a esa cuenta. En Estados Unidos, Twitter ha retirado su verifación a nacionalistas blancos y líderes de extrema derecha como Richard Spencer.

Todos estos cambios llegan desde que en noviembre de 2016 saltara a la luz cómo Twitter y otras redes sociales como Facebook sirvieron para propagar desinformación, intoxicar la conversación pública e incluso manipular procesos electorales en Estados Unidos, Alemania, Reino Unido, Francia y España. La compañía de Jack Dorsey ha sido el foco de muchas críticas por el escaso control sobre los contenidos publicados en su plataforma.

Muchas personas expertas creen que Twitter está intentando encontrar una solución que no existe: aplicar una norma a 330 millones de usuarios y que es difícil volver a cerrar la caja de Pandora. “Reconocemos que nos queda mucho trabajo por hacer”, apunta David Gasca. “Seguiremos siendo transparentes y abiertos con nuestros errores”, señalan en un comunicado.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

Information Technology

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre CiberseguridadVer todo

Christophe Blassiau, Michael Daniel and Michele Mosca

31 de octubre de 2025