Así es como la Inteligencia Artificial adquiere sesgos machistas y prejuicios raciales

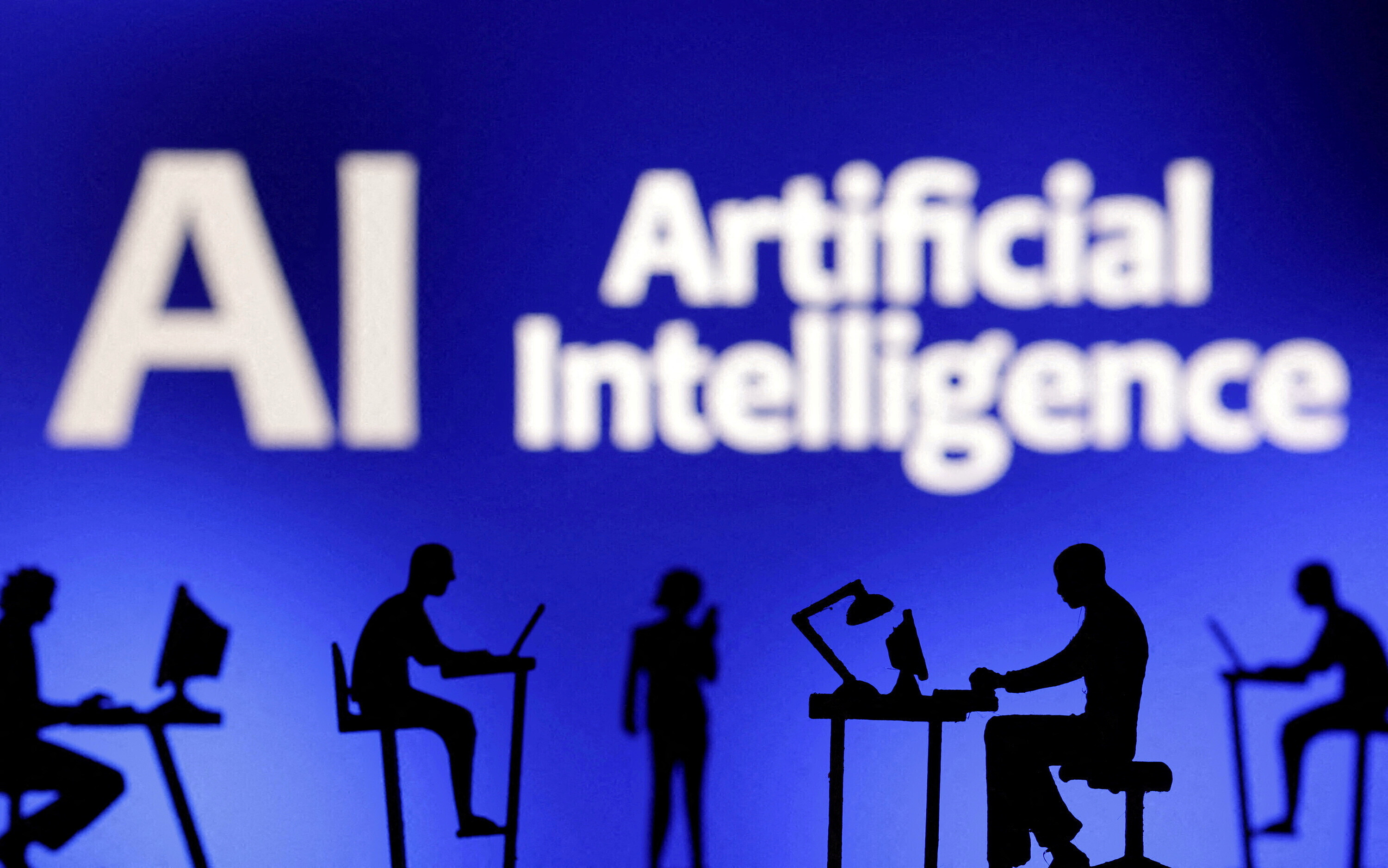

Image: REUTERS/Fabrizio Bensch

Un estudio publicado recientemente en la revista Science muestra que cuando una inteligencia artificial (IA) aprende un idioma, ésta termina por asumir los sesgos humanos que están incluidos implícitamente en el lenguaje. En otras palabras, las máquinas basadas en aprendizaje automático se vuelven racistas y machistas al aprender un lenguaje, porque el lenguaje ya contiene ese tipo de sesgos.

Una máquina puede asumir sesgos de forma directa, a través de los propios programadores, pero también puede hacerlo a través de los datos que utiliza para su aprendizaje.

"Los modelos de aprendizaje automático que están entrenados partir de datos humanos a gran escala pueden desarrollar estereotipos, ya que a partir de esos datos las máquinas son capaces de representar con precisión hechos sobre el mundo y la cultura humana, lo que inevitablemente incluye sesgos", explica a eldiario.es la principal autora del estudio, la investigadora de la Universidad de Princeton, Aylin Caliskan.

La idea básica del trabajo de Caliskan es que algunos aspectos del significado de las palabras pueden ser inducidos a partir de la forma en la que las ordenamos, algo que ha sido tratado en múltiples ocasiones a lo largo de las últimas décadas. Desde mediados de los 90 varios estudios han apuntado a esta posibilidad e incluso algunos de ellos señalan que los niños acaban asumiendo los significados de una palabra gracias al contexto en el que dicha palabra se repite en los distintos discursos que se van encontrando a lo largo de su aprendizaje.

Las máquinas aprenden a leer utilizando estadística

Esta hipótesis es en la que se basan muchos de los métodos de aprendizaje más comúnmente utilizados para enseñar a leer a una máquina. El hecho de que las palabras con significados similares tiendan a repetirse en contextos similares hace que, mediante un análisis estadístico de las palabras, una maquina pueda obtener información para entender su significado.

"Lo que hacemos es buscar la probabilidad que tiene cada palabra de estar rodeado por otras, de esta forma, la IA puede determinar que un perro es más similar a un gato que a una nevera, porque solemos decir voy a casa a darle de comer a mi perro/gato, pero nunca decimos voy a casa darle de comer a mi nevera", explica Joanna Bryson, investigadora principal del proyecto.

A partir de este método de aprendizaje automático, los investigadores desarrollaron una IA que utilizó más de 2 millones de palabras durante su aprendizaje y analizaron la forma en la que ésta asociaba distintas palabras, de forma muy similar a los tests que se realizan con humanos para descubrir sus sesgos inconscientes.

Una IA sexista y con prejuicios raciales

Al hacerlo, Caliskan y Bryson descubrieron que la IA efectivamente reproducía sesgos habituales en los seres humanos. Por ejemplo, la máquina asociaba con mayor probabilidad los nombres femeninos a palabras relacionadas con tareas domésticas o cuestiones familiares, mientras que los nombres masculinos se asociaban a conceptos relacionados con la carrera profesional. Análogamente, la IA también asociaba con mayor probabilidad palabras como "mujer" y "niña" a conceptos relacionados con las artes y menos con las matemáticas.

Por último, las investigadoras también comprobaron como IA también asumía sesgos raciales, dado que asociaba los nombres americanos de origen europeo con estímulos positivos con más probabilidad que los nombres afroamericanos.

"Esencialmente", explica Caliskan, "esto refleja el hecho de que las asociaciones sesgadas tienen lugar de forma frecuente en los textos a los que ha tenido acceso la maquina, hasta el punto de que han terminado dando lugar a estereotipos estadísticamente significativos que han sido reconocidos y aprendidos por la IA". "Si fuéramos capaces de cambiar esta coincidencia de palabras", concluye esta investigadora, "las asociaciones sesgadas que parten del idioma se reducirían".

Las investigadoras aseguran que sus hallazgos no solo son importantes desde el punto de vista de análisis del lenguaje, sino que tienen especial importancia a la hora de desarrollar IAs de aprendizaje automático, dado que estas tecnologías "pueden perpetuar estereotipos culturales". Según Caliskan y Bryson, "si construimos un sistema inteligente que aprenda lo suficiente sobre las propiedades del lenguaje como para poder comprenderlo y producirlo, también adquirirá asociaciones culturales históricas, algunas de las cuales pueden ser censurables".

Traductores sexistas

Uno de los casos analizados por las autoras del estudio, y en el que ya se pueden ver este tipo de sesgos y estereotipos culturales, es el de la traducción automática. Caliskan, de origen turco, pone como ejemplo, el popular traductor de Google, que al traducir frases turcas con pronombres neutros, termina introduciendo pronombres estereotipados por género. Por ejemplo, las frases "O bir doktor. O bir hemsire”, las traduce como " Él es doctor. Ella es enfermera".

Para evitar este tipo de problemas, las investigadoras proponen tratar de abordar una definición explícita de comportamiento aceptable, pero, sobre todo, llaman a la precaución a la hora de utilizar sistemas basados en aprendizaje automático no supervisado en procesos de toma de decisiones. Además, Caliskan aclara que "si tratamos de eliminar los sesgos de IA, podríamos terminar perdiendo algunos datos estadísticos sobre el mundo que pueden ser realmente necesarios para que la máquina funcione de forma precisa".

Con todo, a la hora de reducir los sesgos que pueden aprender las máquinas, Caliskan termina mirando hacía los humanos. "Sabemos que el lenguaje refleja nuestros prejuicios y, aunque no está claro si los seres humanos aprendemos estereotipos a través del lenguaje o si son éstos los que pasan a formar parte de un lenguaje a través del tiempo, lo que sí sabemos es que si el lenguaje es más inclusivo, las asociaciones estereotípicas disminuirán". Al final, concluye esta investigadora, "las IA que desarrollemos no podrán ser del todo imparciales, hasta que lo seamos los seres humanos".

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

Inteligencia Artificial y Robótica

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre Tecnologías emergentesVer todo

Inna Tokarev Sela

13 de noviembre de 2025