La IA y el auge de la 'ingeniería de prompts': Entrevista con Albert Phelps, ingeniero en Accenture

Albert Phelps se incorporó a Accenture como ingeniero de prompts en octubre de 2021.

Listen to the article

- Albert Phelps se incorporó a Accenture como ingeniero de prompts, que se puede traducir como ingeniero de instrucciones, en octubre de 2021.

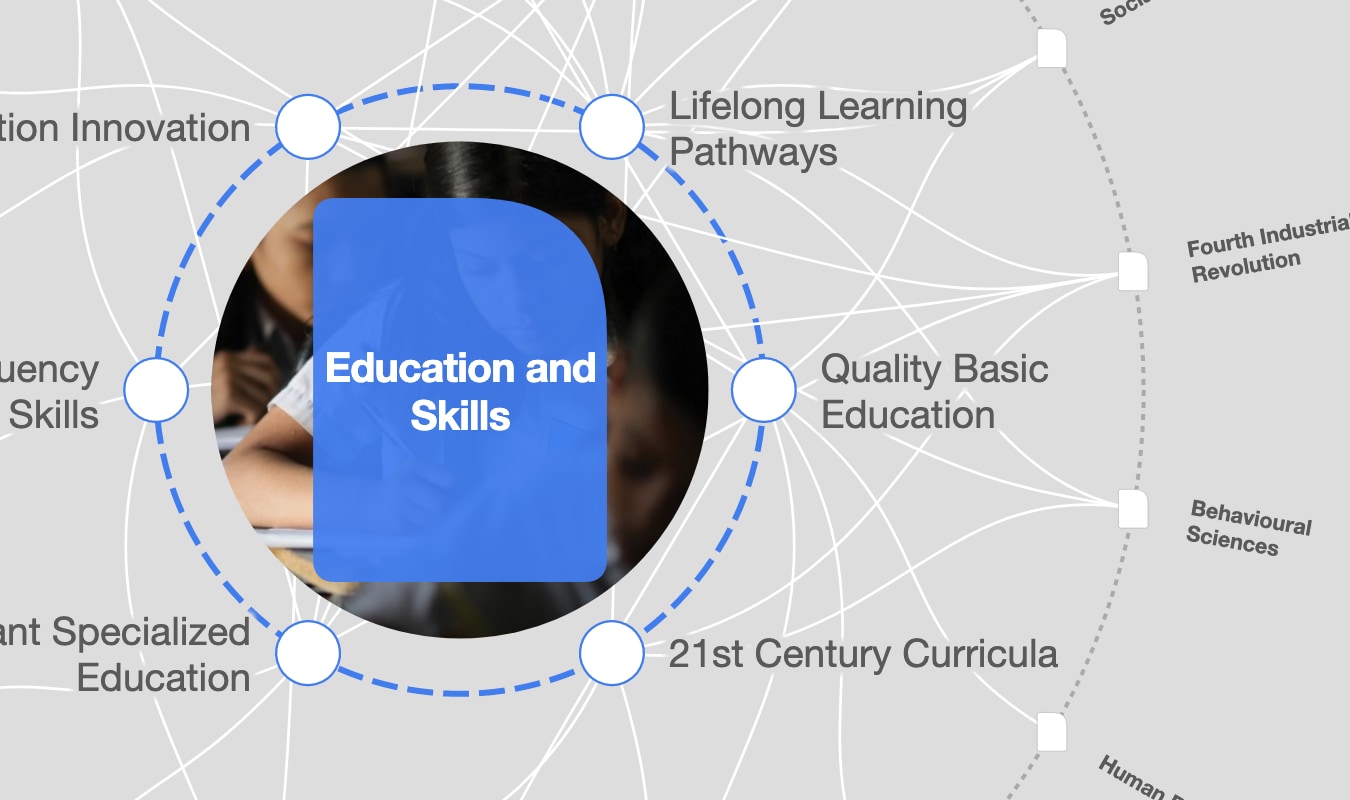

- Desde el lanzamiento de GPT-4 en marzo de 2023, se ha despertado un enorme interés por profesionales que puedan entrenar a los sistemas de IA y aprendizaje automático. Ellos son los empleos de más rápido crecimiento en el mundo, según el Informe sobre el Futuro de los Empleos 2023 del Foro Económico Mundial.

- Phelps explica lo que significa ser un ingeniero de prompts y comparte sus consejos para empleados y organizaciones que deseen mejorar sus cualificaciones.

Albert Phelps cree que algún día todos haremos parte de su trabajo. "Casi todo el mundo se convertirá en algún momento en un ingeniero de prompts, porque se incorporará a todos nuestros flujos de trabajo, supongo".

Desde el lanzamiento del sistema de modelo lingüístico Generative Pre-trained Transformer 4 (GPT-4), en marzo de 2023, la ingeniería destinada a escribir tareas para entrenar herramientas de IA se ha promocionado como uno de los nuevos empleos tecnológicos de moda, con titulares centrados en los salarios de seis cifras que pagan. A esa nueva función, que en inglés se denomina ingeniería de prompts, se le refiere a veces también como ingeniería de instrucciones o ingeniería rápida.

En enero, una sesión de la reunión anual del Foro Económico Mundial en Davos se dedicó al impacto que la IA tendría en el empleo, y se destacó la ingeniería como una función que crecería.

Ahora, los especialistas en IA y aprendizaje automático han encabezado la lista del Foro de los 10 empleos de más rápido crecimiento, en el Informe sobre el Futuro de los Empleos 2023, que también descubrió que el 75% de las empresas encuestadas tenían probabilidades o muchas probabilidades de adoptar la IA en los próximos cinco años.

Las competencias en IA y big data ocupan el tercer lugar entre las prioridades de las empresas en materia de reciclaje, 12 puestos por encima de su evaluación de las competencias básicas, y se prevé que inviertan en ellas el 9 % de sus esfuerzos de reciclaje.

Phelps es ingeniero a tiempo completo en Accenture desde octubre de 2021.

En marzo, Accenture concluyó que, en todos los sectores, los grandes modelos lingüísticos (LLM) como GPT-4 podrían influir en el 40% de las horas de trabajo. Las tareas lingüísticas representan el 62% del tiempo total de trabajo de los empleados, y el 65% de ese tiempo puede hacerse más productivo mediante el aumento y la automatización, afirma.

En esta entrevista, cuyos extractos reproducimos a continuación, Phelps explica en qué consiste exactamente esta función, por qué es crucial mantener a los seres humanos informados y cuáles son sus consejos para quienes quieran convertirse en los ingenieros del futuro.

¿Qué es un ingeniero de prompts y en qué consiste su trabajo diario?

Dedico mi tiempo a pensar en los problemas o retos empresariales que tienen nuestros clientes y a buscar cómo transformarlo en una tarea para que un modelo lingüístico les ayude.

Así que mi día a día podría consistir en averiguar cómo conseguir que un modelo lingüístico comente un informe de resultados del mismo modo que lo haría un analista. Podría ser cómo crear una herramienta que ayude a cumplir la normativa de los servicios financieros.

Se trata de entender la tarea, el objetivo, y luego idear algunas condiciones para probar que el modelo puede hacerlo correctamente, y luego escribir e iterar las indicaciones.

En cierto sentido, es similar a la ingeniería de software, porque intentas llegar a un punto en el que puedas demostrar que algo funciona y optimizarlo. Una de las principales cosas que optimizamos es la longitud de los tokens, porque tokens es igual a coste en términos de inferencia. Intentamos que el modelo contenga el mayor número posible de significados e instrucciones útiles en el menor espacio posible. Así que trabajo con los clientes para entender algunos de los retos e intereses que tienen y luego diseñar mensajes y aplicaciones construidas con esos mensajes para satisfacer esos problemas y objetivos empresariales.

¿Qué está haciendo el Foro Económico Mundial para aumentar la inteligencia digital de la población infantil?

¿Cómo aumenta la IA su trabajo?

Es un diseño muy humano. Es un diálogo que mantienes con el modelo mientras intentas probarlo y hacerle sugerencias.

Hay diferentes técnicas para dar instrucciones, así que yo empezaría con una "instrucción cero". Es decir, yo reduzco la tarea a una serie de instrucciones que el modelo debe seguir, sin ejemplos. Entonces echamos un vistazo y decimos: "Bueno, ha hecho bien esta parte de la tarea, pero no ha hecho tan bien esta otra". Así que entonces podrías darle al modelo un ejemplo de esa tarea realizada.

Muchos de mis casos de uso han sido en los servicios financieros y bancarios porque esa es mi formación. Sé más que el modelo sobre un tema o, al menos, tengo los mismos conocimientos, lo cual es importante porque hay que ser capaz de detectar si el modelo acierta las respuestas y si las falla. Una vez que se han escrito las instrucciones y se han incorporado a la aplicación, y el modelo las sigue de forma coherente, yo seguiría queriendo contar con la participación de un ser humano en la fase de producción, ya que se trata de una nueva tecnología con riesgos asociados.

Además, desde la perspectiva de disfrutar del trabajo, creo que un uso de tipo aumentativo en general es mejor para las personas que hacen su trabajo. Algunas tareas son frustrantes o difíciles: ¡me encantaría tener, por ejemplo, un robot que pudiera gestionar mi agenda! Yo diría que en el 95% de los casos en los que trabajo, incluso una vez que hemos llegado al punto de desarrollar una ayuda de alta calidad, vamos a seguir imaginando a un humano en control cuando esto pase a producción, simplemente porque se trata de una nueva tecnología.

¿Qué son exactamente los tokens?

Los tokens son parte de las palabras, esencialmente el modelo de cobro de los modelos de código cerrado como GPT-4 de OpenAI y Claude de Anthropic. Su estructura de cobro suele basarse en cuántos tokens consumes a medida que construyes tu aplicación con ese modelo. Hay limitaciones en cuanto a la cantidad que puedes poner dentro de lo que se llama la ventana de contexto de ese modelo. Así que tienes que ser eficiente en la forma en que deseas consultarlo, tanto desde el punto de vista del coste, como en términos de dar a las personas que utilizan la cosa que has construido la oportunidad de ser capaz de conectarse con ella y tener más de una interacción con ella antes de que use toda su memoria. También hay mitigaciones técnicas para eso.

Gran parte del trabajo que estoy estudiando ahora trata sobre cómo combinar múltiples modelos. Suelo fijarme más en eso cuando se trata de una aplicación de producción que cuando me dedico a juguetear con las instrucciones para encontrar nuevos casos de uso y puntos de prueba.

¿Qué es una buena instrucción?

Cada modelo tendrá una forma sutilmente diferente de instrucción ideal. Existen algunas técnicas comunes, como el "zero-shot" y el "few-shot prompting". Pero para un prompt típico, inicialmente, trataría de ejemplificar dentro del modelo, no necesariamente una personalidad, sino un papel que quisiera que desempeñara y que registraría dentro del prompt del sistema.

Así que, por ejemplo, si yo estuviera mirando a un asistente de investigación de cumplimiento, probablemente diría: "Esto es en lo que eres bueno. Esto es lo que debes tener en cuenta como tus limitaciones, tu corte de datos de formación es X", y luego si quieres empiezas a complicarte un poco más dentro de esa instrucción del sistema.

Trabajo mucho con marcos de inferencia de selección, lo que significa dar instrucciones al modelo, antes de que dé su respuesta, para que seleccione a partir del contexto que le doy. Puede ser dentro de la consulta o llamando a una base de datos externa, para que seleccione la información pertinente en función de la pregunta que le estoy formulando. Y luego hacer una inferencia a partir de esa información mientras da su respuesta. Así que estás dividiendo cómo el modelo está volviendo a ti con una respuesta. Eso es útil para el diagnóstico, porque se puede decir: "El modelo tiene esta respuesta incorrecta. ¿Es porque seleccionó la información incorrecta o porque hizo una inferencia incorrecta de esa información?"

Ese tipo de ingeniería me parece muy interesante. Apareció en 2022 con un artículo de DeepMind y Antonia Creswell. Lo bueno de esto es que te permite inspeccionar cómo el modelo está haciendo sus respuestas y mitigar algunos de los desafíos que todo el mundo probablemente conoce, que es la naturaleza de caja negra de algunos de estos modelos. Estamos tratando de conseguir que nos muestre cómo está llegando a las respuestas y que nos de una manera de conseguir lo que se llama un rastro de razonamiento causal en lenguaje natural para que podamos ver: el usuario hizo esta pregunta, el modelo seleccionó estos datos, el modelo hizo esta inferencia, aquí está la respuesta.

¿Cuál fue su trayectoria profesional hasta llegar a ser ingeniero?

Mi carrera siempre ha estado ligada a las palabras en los servicios financieros. Empecé en la primera línea de la banca minorista. Gestioné reclamaciones, comprobé la calidad del cumplimiento y trabajé en soluciones bancarias, que implicaban datos porque pensabas en el impacto que tenía en el cliente si algo iba mal en el banco y en cómo atribuirle un valor monetario y presentar las disculpas al cliente.

Luego me dediqué más al cumplimiento basado en riesgos y trabajé en la privacidad de los datos y la ciberseguridad, es decir, examinando lo que dicen las normativas y ayudando a los técnicos a cumplirlas. Empecé a adentrarme más en el espacio tecnológico, buscando automatizar los controles y hacerlos más fiables.

Leí sobre GPT-3 a finales de 2020/principios de 2021. En la zona de juego empecé a hacer preguntas sobre mis propios conocimientos en materia de regulación y ciberseguridad. Era muy bueno copiando, si le hablabas de una manera determinada, te respondía de la misma manera. Fue impresionante, porque no representaba directamente mis intenciones, que es como funcionaba antes el procesamiento del lenguaje natural. Eso era bastante mecánico, pero esto ahora captaba de forma natural la forma en que yo le hablaba y me respondía. Pero era mucho más difícil de instruir que hoy.

En ese momento, pensé, esto es super interesante. Quiero dedicarme a esto a tiempo completo. Tuve la suerte de dar con Accenture. Desde entonces, he estado trabajando en la creación de prompts y, más allá de eso, productos para nuestros clientes como resultado de ese viaje.

¿Qué habilidades se necesitan para ser un ingeniero de prompts?

Es importante ser claro y económico a la hora de escribir. La gente de inglés, historia y filosofía se alegra porque puedes interactuar con estos modelos tan avanzados sólo con palabras, lo cual es impresionante.

Pero paralelamente a la construcción de esas indicaciones sólo con palabras, también he estado en un viaje de aprendizaje de cómo incorporarlas en aplicaciones técnicamente. Así, por ejemplo, la línea de modelos GPT y GitHub CoPilot me han hecho mucho mejor en la codificación. Ahora no sólo soy capaz de utilizar y construir prompts dentro de la zona de juegos de OpenAI o cualquiera de los otros proveedores de LLM que nuestros clientes están interesados en utilizar, sino que también estoy pasando a la interfaz de línea de comandos y construyendo aplicaciones gracias a esa tecnología.

Entonces, ¿no hace falta tener conocimientos de informática?

Hay algunos científicos de datos increíbles con los que trabajo que también son fantásticos ingenieros. Lo que lo hace único es que puedes abordarlo desde cualquier lado y encontrarte en el medio. Las prácticas básicas de desarrollo de software seguirán siendo relevantes para la ingeniería de prompts. Pero si eres capaz de expresarte con palabras, está la cita de Andrej Karpathy: "El nuevo lenguaje de programación más caliente es el inglés".

Yo diría que eso se está confirmando en la forma en que desarrollamos cosas con nuestros clientes. Siempre me ha interesado el aspecto técnico de las cosas, pero ahora no hay tanta barrera de entrada si no tienes una formación completamente técnica. Probablemente lo hayas visto con otros ingenieros que a menudo tienen formación en humanidades, lo cual es estupendo. La diversidad de puntos de vista y de experiencias solo mejorará los productos que construyas y las soluciones en las que puedas trabajar.

¿Cómo se sortean los riesgos asociados a la IA generativa?

Creo que siempre habrá un equilibrio entre los modelos de código abierto y cerrado. Las organizaciones deberían perfeccionarse en términos de mejorar su modelo y con ello me refiero a más ejemplos que seas capaz de mostrar al modelo.

Lo que les digo a mis clientes es que se fijen tanto en los modelos de código abierto como en los de código cerrado. Pero yo diría que la diferencia de rendimiento en la actualidad entre los modelos de código abierto y cerrado en lo que respecta al texto sigue siendo bastante grande.

Esto se reduce simplemente al número de parámetros y al tamaño de los modelos que pueden crear OpenAI, Cohere o Anthropic. Y también la experiencia que tienen dentro de esos laboratorios de investigación para hacer el aprendizaje de refuerzo de la retroalimentación humana, lo que hace que los modelos sean más útiles, capaces de seguir mejor las instrucciones.

Así que ten cuidado con lo que pones ahí y podemos hablar de todas las diferentes facetas de los diferentes proveedores de modelos y las condiciones que ofrecen.

¿Qué ha cambiado desde que se empezó a hablar de ingeniería de prompts?

Tuve seis meses de hacer esto en paz dichosa, sólo conseguir en escribir mensajes. Los últimos seis meses, desde que Chat-GPT se hizo viral, han sido muy diferentes, porque ahora se trata mucho más de cómo formar a un montón de gente para que lo haga, de cómo hablar de ello.

Pero tenemos algunos ingenieros de gran calidad que están aprendiendo de mí y de toda la gente de Accenture que tiene este conocimiento. Personas como Noelle Russell, directora global de soluciones de IA para el grupo de datos e IA de Accenture Cloud First, quien ha estado impartiendo formación para todos los empleados de Accenture que quieren entenderlo.

Se ha convertido en algo mucho más viral de lo que yo esperaba, porque cuando solía interactuar con GPT-3, incluso en aquellos días, se podía ver en ese momento que iba a ser transformador, pero se fue diluyendo. La zona de juegos de Open AI tardó varios años en acercarse al millón de usuarios. Con GPT-4, ha ocurrido en un periodo de tiempo increíblemente corto. Pero todo es bueno, porque significa nuevas cosas con las que probar el modelo y nuevas oportunidades para construir cosas.

¿Qué impacto cree que tendrá la IA en el empleo?

No soy nada pesimista en cuanto al empleo. Creo que será algo positivo. El modelo LLM más maduro en el mercado es probablemente GitHub CoPilot, que probablemente ha existido durante casi dos años.

Si hablas con desarrolladores que lo utilizan, echas un vistazo a GitHub y a los estudios de otras personas, les encanta porque les facilita mucho el trabajo. El copiloto escribirá el código, podrán comprobar que están satisfechos con él y, a continuación, podrán ejecutarlo.

Hoy he visto un estudio de Stanford en el que se hablaba de cómo un gestor de llamadas relativamente inexperto podía ser asistido por IA generativa mientras hablaba con un cliente. Este es el estado de ánimo del cliente, esto es tal vez lo que debes decir a continuación. No tenía que hacerlo, pero podría. Creo que mejoró tanto su rendimiento que se parecían más a alguien que llevaba allí seis meses o un año.

A las personas que acaban de incorporarse a un puesto, les dará la posibilidad de autorrealizarse y reducir el tiempo que dedican a ser productivas. A todo el mundo le gusta sentir que está haciendo un buen trabajo, y ahí es donde entraría en juego la IA generativa.

Mi compañera, Rikki Turner, es artista y se inspira mucho en la IA generativa. Toma un cuadro que crea, lo pasa por un modelo de imagen a texto y luego obtiene un título para su cuadro creado por la interpretación de la IA.

Creo que la gente que piensa que todo esto va a ser automatización subestima el poder y la flexibilidad de la mente humana.

Nos encantan las cosas nuevas, pero luego nos adaptamos a ellas superrápidamente.

”¿Qué consejo daría a la gente que quiere dedicarse a la ingeniería de prompts?

Lee sobre el tema. Hay unos cuantos artículos, hay algunos clásicos de 2022 sobre razonamiento en cadena de pensamiento, razonamiento en cadena de pensamiento de disparo cero, y luego el marco de inferencia de selección. Ésas son las mejores introducciones técnicas a la ingeniería de prompts y por qué funciona. Con los modelos más antiguos, podías hacerle una pregunta de matemáticas, aritmética simple, y se equivocaba. Si le añadimos la frase "Pensemos paso a paso", el modelo resolverá el problema paso a paso y obtendrá la respuesta correcta.

Ese es el poder de la ingeniería y de elegir las palabras adecuadas, porque descubres capacidades emergentes en el modelo que no sabías que existían hasta que encontraste las palabras adecuadas. Así que lee los artículos académicos, pero también juega con los modelos.

Hay numerosas API y aplicaciones disponibles para probar los últimos modelos fundacionales, de empresas como OpenAI, Anthropic y Cohere, incluidos OpenAI Playground, Chat-GPT, Cohere Playground y Claude de Anthropic.

Es la mejor manera de aprender, porque empezarás, por ensayo y error, a darte cuenta de cuál es tu voz y a entender cuál es la mejor manera de escribir prompts que se adapten a ti y a lo que quieres hacer.

”¿Cómo podemos incorporar resiliencia a la función?

Es interesante porque el otro día vi un artículo que hablaba de un escritor automático de instrucciones para LLMs que utiliza LLMs. Es posible que haya visto algunos de los bombos alrededor de Auto-GPT donde le das una instrucción y luego hace cosas por sí mismo.

No soy imparcial, pero creo que (el elemento humano) seguirá existiendo porque la IA generativa es relativamente arriesgada y, como decimos a nuestros clientes, siempre hay que contar con la participación de un ser humano, al menos en la fase de diseño y en la fase de pruebas para validar que es correcta.

La forma de instruir cambia prácticamente cada vez que se cambia de modelo, así que hay que ser adaptable y tener un conocimiento básico de la tecnología subyacente (no hace falta saber matemáticas, pero sí cómo funciona). ¿Cuál es la mejor manera de generar los comportamientos que quiero? Creo que será una función que se mantendrá en un sentido especializado en lo que respecta a cómo conseguir que los LLM realicen estas tareas de forma eficaz, segura y responsable.

Pero también creo que, en algún momento, casi todo el mundo se convertirá en ingeniero de prompts, porque se incorporará a todos nuestros flujos de trabajo.

Pero aún tendremos que saber cuál es la pregunta correcta, ¿no? Así que creo que todo el mundo asumirá algo de esto en algún momento.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

Education, Gender and Work

Temas relacionados:

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre Foro en focoVer todo

Gayle Markovitz

29 de octubre de 2025