El mayor estudio sobre la ética de los coches autónomos trae malas noticias para los ancianos (e incertidumbre sobre el futuro)

Image: REUTERS/Stephen Lam

Mantente al día:

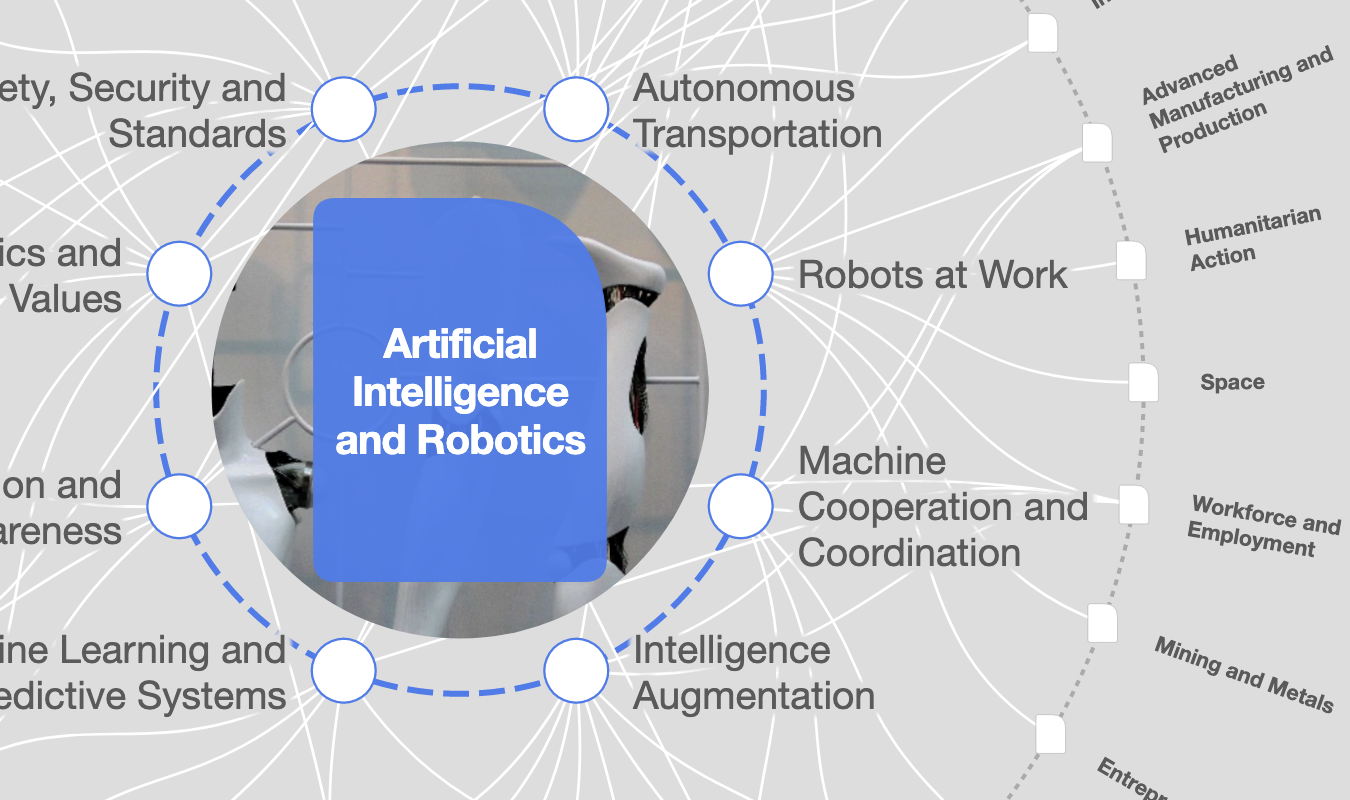

Tecnologías emergentes

300.000 vidas cada década. Eso es lo que podrían conseguir los coches automáticos solo en EEUU. Sin embargo, no es tan sencillo como parece. Conducir un coche no es sólo una cuestión mapear el entorno y seguir las normas de circulación: es tomar decisiones complejas en cuestión de segundo. Y el problema es que hay muchas cosas que no sabemos programar.

En 2016, un grupo de investigadores del MIT Media Lab crearon ‘Moral Machine’, un juego de ética que planteaba a los participantes el tipo de cuestiones éticas que, dentro de poco, tendrán que resolver los vehículos sin conductor. Han reunido más de cuatro millones de respuestas y ahora tenemos los primeros resultados.

El código moral

«No abrimos el cerebro de la gente para analizar sus neuronas y ver si son éticas, lo que hacemos es observar su comportamiento». Así explicaba Iyad Rahwan, profesor del MIT, el proyecto en el que se basa 'Moral Machine'. Con él, Rahwan aspira a encontrar un consenso moral para resolver preguntas cruciales que, en los próximos años, decidirán la vida y la muerte de muchas personas en carreteras de todo el planeta.

Desde el lanzamiento de ‘Moral Machine’ en 2016, más de cuatro millones de personas participaron en el test y respondieron cosas como "¿Qué vida debe proteger un coche autónomo la de sus ocupantes, la de los peatones, la de otros ocupantes? ¿De qué depende esa elección? ¿De la edad, del género, del número, de la especie de los implicados?".

Se incluyeron decenas de combinaciones que tratan de captar los factores de los que depende el juicio moral. La tarea es colosal. Tanto que según el propio Rahwan, a día de hoy se trata del estudio de ética global más grande jamás realizado.

Y no, no está completo. Está previsto que los resultados se publiquen a finales de año, cuando quedarán disponibles para ser utilizados por quien quiera dotar de ‘programación moral’ a los robots. Pero tras el primer atropello mortal de un peatón, Rahwan ha revelado algunas conclusiones en el Foro Global de Educación y Habilidades en Dubai.

Por ahora no hay acuerdo

El equipo de Rahwan descubrió que, cuando se trata opciones simples como golpear a un niño o a un adulto, los resultados son claros: al adulto. De hecho, cuánto ancianos son los peatones, más 'prescindibles' son a ojos de los participantes del experimento.

Sin embargo, cuando los dilemas se volvían más complejos, el acuerdo desaparecía. Por ejemplo, la disyuntiva entre atropellar a una persona cruzando la carretera legalmente y atropellar a dos personas que la están cruzando de forma ilegal, las respuestas se dividían al 50%.

Si estaba en juego la vida del participante, hasta el 40% de los participantes declararon que daba igual a quién hubiera que matar. Lo principal era preservar la vida del participante. Esto es tremendamente interesante porque, aunque no lo parezca, lo que tenemos entre manos va más allá de los coches autónomos. En realidad, estamos ante el intento de resolver uno de los grandes temas irresueltos de la Historia.

¿Sabemos lo que es el bien?

Ante esto, hay dos grandes posturas fundamentales. La de Derek Parfit que piensa que, aunque todas las tradiciones morales parecen distintas, en realidad son como escaladores subiendo la misma montaña por diferentes rutas. Es decir, hay diversidad de valores y normas morales, pero todas acaban convergiendo en la cima.

Frente a él, Alasdair MacIntyre defendía que aún no hemos llegado a un consenso moral sobre qué es bueno y qué es malo porque nuestros valores son incompatibles entre sí. Son tradiciones sociales y comunitarias enfrentadas (y esto es crucial) en su aplicación de la racionalidad práctica. Es decir, no seremos capaces de encontrar un consenso general para cada problema ético con el que nos encontremos.

Llevamos siglos discutiendo sobre este tema y, por primera vez, hemos desarrollado un gran experimento capaz de arrojar un resultado práctico. ¿Seremos capaces de programar moralmente automóviles para que actúen correctamente? ¿Existe una concepción del bien en la que estemos todos de acuerdo? 'Moral machine' tiene mucho que decir sobre el futuro de la robótica.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Puedes anular tu suscripción en cualquier momento utilizando el enlace que figura en nuestros correos electrónicos. Para obtener más información, consulta nuestro Política de privacidad.

Más sobre Tecnologías emergentesVer todo

Joseph Wehbe

21 de julio de 2024

David Elliott

21 de julio de 2024

Stefanie Ólives

19 de julio de 2024

David Elliott

4 de julio de 2024

Cathy Li

4 de julio de 2024

David Elliott

4 de julio de 2024