¿Cómo detectar un deepfake? Esto dicen los expertos

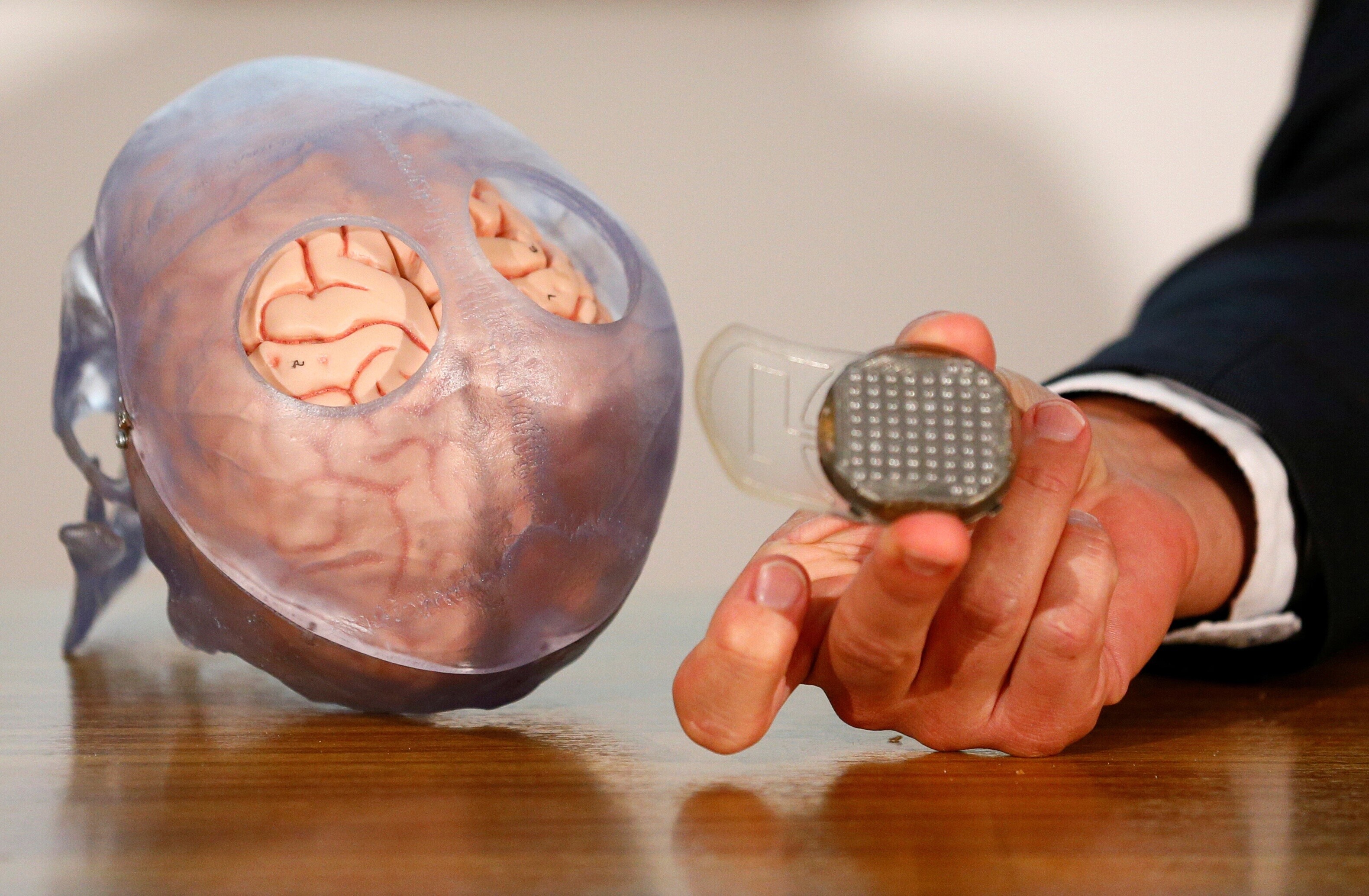

La tecnología deepfake está siendo utilizada para cometer delitos en línea. Image: Reuters

- Los deepfakes -vídeos, imágenes o audios realistas, pero fakes, de personas- se están utilizando para cometer delitos financieros y sexuales.

- Los expertos comparten consejos sobre cómo detectar un deepfake, pero no son infalibles.

- La Tipología de Daños en Línea del Foro Económico Mundial proporciona un lenguaje común y universal para promover la seguridad digital.

Cuando vemos a Taylor Swift regalando utensilios de cocina o a Donald Trump bailando con Elon Musk, nuestras alarmas de deepfake se encienden.

Pero los deepfakes -en los que se utiliza la IA para crear vídeos, imágenes o clips de audio hiperrealistas, pero falsos, de personas - no siempre son divertidos o fáciles de detectar.

A finales de 2023, grabaciones de audio falsas arruinaron a uno de los principales candidatos en las elecciones de Eslovaquia. A principios de 2024, un empleado de Hong Kong fue engañado para que pagara 25 millones de dólares a estafadores después de que fingieran una videoconferencia con él.

¿Qué está haciendo el Foro Económico Mundial en el ámbito de la cuarta revolución industrial?

En un año récord de elecciones en todo el mundo, los candidatos a cargos políticos están comprensiblemente nerviosos por la situación. Y no les falta razón: un nuevo estudio revela que los deepfakes que se hacen pasar por políticos y celebridades "para influir en la opinión pública" son el caso de uso indebido más común de la tecnología, más que la ciberdelincuencia.

Cómo detectar un deepfake?

Con un 60% de adultos estadounidenses preocupados por los deepfakes, saber identificarlos se está convirtiendo en una habilidad crucial.

El MIT Media Lab ofrece algunas señales reveladoras para tener en cuenta en los visuales de deepfakes, incluyendo:

1. Parpadeo y movimientos de labios: estudiarlos para ver si siguen ritmos naturales.

2. Reflejos en los ojos y las gafas: ¿son consistentes y tienen sentido visual?

3. ¿La edad de la piel coincide con la de los ojos y el cabello?

Todo está en los ojos, según una nueva investigación de la Universidad de Hull en el Reino Unido. Si el sujeto tiene un reflejo coincidente en cada ojo, es probable que sea una imagen real, pero si hay inconsistencia en los dos reflejos, probablemente sea fake.

"Hay falsos positivos y falsos negativos; (el método) no va a detectar todo", advierte el profesor Kevin Pimbblet, uno de los investigadores. "Pero este método nos proporciona una base, un plan de ataque, en la carrera armamentista para detectar deepfakes".

Los deepfakes y la ley

No sólo los políticos y celebridades pueden sufrir las consecuencias de los deepfakes.

La pornografía deepfake -en la que se manipula la imagen de una persona para que parezca que está realizando un acto sexual- se está convirtiendo en un gran problema, sobre todo en Corea del Sur, que está experimentando "una epidemia de delitos sexuales digitales", informa la BBC.

La policía de Corea del Sur ha atendido 297 delitos sexuales con deepfake en lo que va de año, según Reuters, y la mayoría de las víctimas y los autores son adolescentes.

En el Reino Unido, más de la mitad de los menores de 18 años están preocupados por la posibilidad de ser víctimas de pornografía deepfake, y el gobierno está tomando medidas para abordar el problema, tipificando como delito penal la creación de una imagen deepfake sexualmente explícita.

En la actualidad, no existe legislación en Estados Unidos que prohíba, o incluso regule, los deepfakes - a pesar de que se ha informado de un aumento del 1740% en el fraude con deepfakes en 2023. Sin embargo, la Comisión Federal de Comercio está redactando nuevas leyes para prohibir la producción y distribución de deepfakes haciéndose pasar por individuos.

¿Cómo podemos combatir los deepfakes?

Mientras la ley lucha por mantenerse al día, aquí hay algunas otras formas en que las empresas y la sociedad están tratando de abordar el problema de los deepfakes:

La Universidad de Stanford está utilizando IA para detectar el uso malicioso de la IA, por ejemplo. La misma herramienta que originalmente desarrolló para ayudar a los editores a insertar o eliminar palabras habladas de los videos de manera fluida fue cooptada por personas que hacen deepfakes. Para combatir esto, los investigadores de Stanford han creado una herramienta que puede detectar la tecnología de sincronización labial en el 80% de los casos de falsificación.

La tecnología blockchain puede ayudar a combatir los deepfakes, afirma Scott Doughman, director de negocio de Seal Storage Technology, ya que puede "reducir las vulnerabilidades asociadas con los puntos únicos de fallo".

Educar al público para que tenga una mentalidad de confianza cero cuando se trata de contenido en línea es otro elemento disuasorio clave, argumenta Anna Maria Collard, Vicepresidenta Senior de KnowBe4 África.

La "detección de vida" se está convirtiendo en un elemento adicional esencial en los sistemas de identidad biométrica, afirma Ricardo Amper, fundador y CEO de Incode Technologies. "Por ejemplo, si un control de seguridad requiere un selfie para el reconocimiento facial, un delincuente podría intentar presentar una foto o un vídeo en lugar de un selfie de la vida real. La detección de vida puede combatir estos esfuerzos ayudando a determinar si se trata de una persona real y viva en el selfie."

La Tipología de Daños En Línea (Typology of Online Harms), del Foro Económico Mundial, que clasifica los deepfakes como "medios sintéticos engañosos", proporciona un lenguaje común y universal para avanzar en la seguridad digital. Reconociendo que la IA es una tecnología en constante evolución que "puede dar lugar a nuevas formas de daño o exacerbar las ya existentes", su intención es proporcionar un marco integral a partir del cual las partes interesadas puedan crear ecosistemas digitales más seguro.

No te pierdas ninguna actualización sobre este tema

Crea una cuenta gratuita y accede a tu colección personalizada de contenidos con nuestras últimas publicaciones y análisis.

Licencia y republicación

Los artículos del Foro Económico Mundial pueden volver a publicarse de acuerdo con la Licencia Pública Internacional Creative Commons Reconocimiento-NoComercial-SinObraDerivada 4.0, y de acuerdo con nuestras condiciones de uso.

Las opiniones expresadas en este artículo son las del autor y no del Foro Económico Mundial.

Mantente al día:

Ciberseguridad

Temas relacionados:

La Agenda Semanal

Una actualización semanal de los temas más importantes de la agenda global

Más sobre CiberseguridadVer todo

Christophe Blassiau, Michael Daniel and Michele Mosca

31 de octubre de 2025